- Λήψη συνδέσμου

- X

- Ηλεκτρονικό ταχυδρομείο

- Άλλες εφαρμογές

Το Πεντάγωνο κατασκευάζει ένα στρατό “αυτοσυνείδητων” ρομπότ δολοφόνων που θα τροφοδοτείται από τα μέσα κοινωνικής δικτύωσης

Αναρτήθηκε από

Ασκητής

- Λήψη συνδέσμου

- X

- Ηλεκτρονικό ταχυδρομείο

- Άλλες εφαρμογές

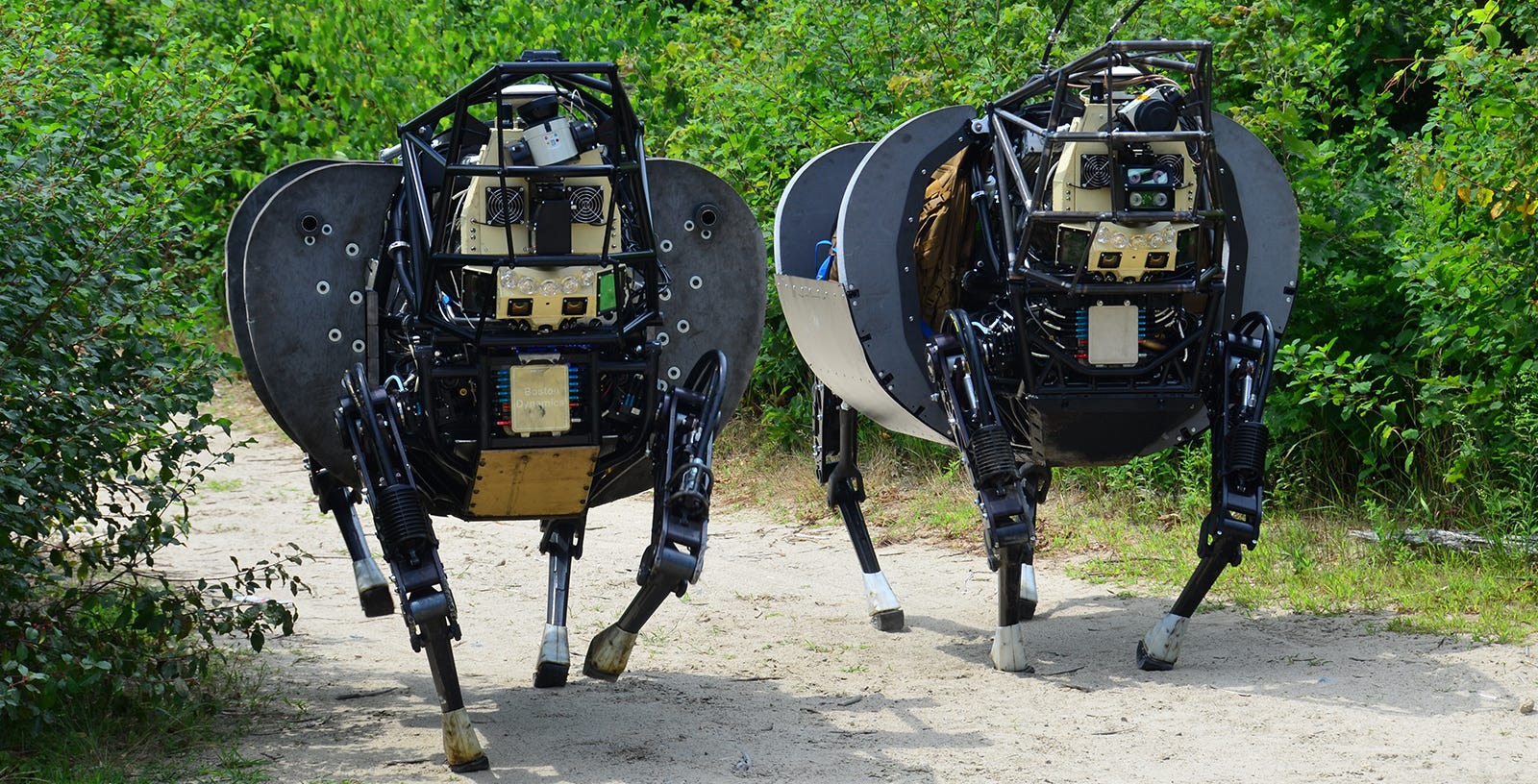

Φανταστείτε ένα από αυτά τα οπλίσμένα ρομπότ-σκυλιά να σας κυνηγάει μέσα στη ζούγκλα, επειδή το όνομα σας εμφανίστηκε σε μία λίστα θανάτου του Πενταγώνου ,αφού κοινοποιήσατε εξοργισμένες δημοσιεύσεις στα κοινωνικά μέσα δικτυωσης.

Επίσημα αμυντικά έγγραφα των ΗΠΑ και του ΝΑΤΟ επιβεβαιώνουν ότι αυτόνομα οπλικά συστήματα θα σκοτώνουν στόχους, συμπεριλαμβανομένων και αμάχων πολιτών, βάσει tweets, ιστολογίων και Instagram.

12/05/2016

Ο

Δρ Nafeez

Ahmed είναι

δημοσιογράφος ερευνητής, συγγραφέας

μπεστ σέλλερ και ειδικός επί της διεθνούς

ασφάλειας. Έγραφε στο παρελθόν για

την Guardian, και είναι ο συγγραφέας της

στήλης «System Shift» για το Motherboard

του VICE και αρθρογραφεί εβδομαδιαία για

το Middle East Eye.

Κέρδισε

βραβείο ερευνητικής δημοσιογραφίας

(Project Censored Award for Outstanding Investigative Journalism ) το

2015 για τη δουλειά του στην Guardian, και

επιλέχθηκε δύο φορές, το 2014 και το 2015

,στη λιστα των 1.000 κορυφαίων Λονδρέζων

παγκοσμίως της Evening Standard.

Ο

Nafeez έχει επίσης συγγράψει και έχει κάνει

ρεπορτάζ μεταξύ άλλων για τον Independent,

το Sydney Morning Herald, The Age, The Scotsman, Foreign Policy,

The Atlantic, Quartz, Prospect, New Statesman, Le Monde diplomatique,

New Internationalist, The Ecologist, Alternet, Counterpunch,

Truthout.

Είναι

Επισκέπτης Ερευνητικός Συνεργάτης στη

Σχολή Επιστημών και Τεχνολογίας του

Πανεπιστημίου Anglia Ruskin, όπου ερευνά τη

σχέση μεταξύ παγκόσμιων συστημικών

κρίσεων και αστικών αναταραχών για τα

Springer Energy Briefs.

Ο

Nafeez είναι ο συγγραφέας ,του A

User Guide to the Crisis of Civilization: And How to Save It (2010),

και του μυθιστορήματος θρίλερ επιστημονικής

φαντασίας ZERO

POINT . Συνέβαλε

επίσημα με τη δουλειά του σχετικά με τα

βασικά αίτια και τις μυστικές επιχειρήσεις

που συνδέονται με τη διεθνή τρομοκρατία,

στην Επιτροπή 9/11 και την Ακροαματική

Διαδικασία για το τρομοκρατικό χτύπημα

της 7/7 στο Λονδίνο.

Αυτή

η

αποκλειστικότητα

δημοσιεύτηκε στο

INSURGE

INTELLIGENCE ,

ένα ερευνητικό πρόγραμμα δημοσιογραφικής

χρηματοδότησης για τα παγκόσμια κοινά.

Σε

ένα μη

απόρρητο έγγραφο του Υπουργείου Άμυνας

(DoD) του 2016, ονόματι Human

Systems Roadmap Review ,

αποκαλύπτεται

ότι ο στρατός των ΗΠΑ σχεδιάζει να

δημιουργήσει αυτόνομα οπλικά συστήματα

τεχνητής νοημοσύνης (Artificial

Intelligence) , τα οποία θα χρησιμοποιούν προγνωστική

ανάλυση για τα μέσα κοινωνικής δικτύωσης,

ώστε να λαμβάνουν αποφάση αν απαιτείται

θανατηφόρο χτύπημα, με ελάχιστη ανθρώπινη

εμπλοκή.

Παρά

τον επίσημο ισχυρισμό

ότι οι άνθρωποι θα διατηρήσουν έναν

«ουσιαστικό» βαθμό ελέγχου επί των

αυτόνομων οπλικών συστημάτων, αυτό και

άλλα έγγραφα του Πενταγώνου της

περιόδου 2015 -2016 επιβεβαιώνουν ότι

οι στρατιωτικοί σχεδιαστές των ΗΠΑ

αναπτύσσουν ήδη τεχνολογίες σχεδιασμένες

για να επιτρέπουν σε σμήνη

«αυτοσυνείδητων» διασυνδεδεμένων

ρομπότ, να σχεδιάζουν και

να εκτελούν δολοφονίες

εναντίον στόχων που έχουν επιλεγεί

επίσης από ρομπότ.

Σε

πιο ανησυχητικό βαθμό,

τα έγγραφα δείχνουν ότι το

υπουργείο Άμυνας

πιστεύει ότι στα

μόλις επόμενα

δεκαπέντε χρόνια, θα είναι εφικτό να

ανατεθεί εξ ολοκλήρου ο προγραμματισμός

της αποστολής, η επιλογή στόχων και η

εκτέλεση

θανατηφόρων χτυπημάτων σε αυτόνομα

οπλικά συστήματα και στον αέρα, και στην

τη ξηρά και στην θάλασσα. Το Πεντάγωνο

αναμένει ότι οι εκτιμήσεις απειλών που

θα γινονται από την τεχνητή νοημοσύνη

γι αυτές τις αυτόνομες αποστολές, θα

προέρχονται από τεράστια σύνολα

δεδομένων, που θα έχουν συλλεχθεί από

ιστολόγια, ιστοτόπους και δημοσιεύσεις

σε πλατφόρμες κοινωνικών μέσων όπως το

Twitter, το Facebook και το Instagram.

Το

σύνολο των εγγράφων του Πενταγώνου

έρχεται σε αντίθεση με την άρνηση του

υφυπουργού Άμυνας Robert Work ότι το υπουργείο

Άμυνας σχεδιάζει να αναπτύξει δολοφονικά

ρομπότ.

Σε

μια ευρέως δημοσιευμένη συζήτηση

τον Μάρτιο, με τον αρθρογράφο

της Washington

Post ,

David Ignatius, ο Work είπε ότι αυτό μπορεί να

αλλάξει καθώς οι αντίπαλες δυνάμεις

εργάζονται για τη δημιουργία τέτοιων

τεχνολογιών:

«Θα

μπορούσαμε να αντιμετωπίσουμε έναν

ανταγωνιστή που είναι πιο πρόθυμος να

μεταβιβάσει την εξουσία σε μηχανές από

ό, τι είμαστε εμείς, και καθώς αυτός ο

ανταγωνισμός ξεδιπλώνεται, θα πρέπει

να λάβουμε αποφάσεις για το πώς μπορούμε

καλύτερα να ανταγωνιστούμε».

Ωστόσο,

επέμεινε, «Δεν θα αναθέσουμε τη εξουσία

θανάτου σε ένα μηχάνημα, ώστε να λαμβάνει

αποφάσεις», παρά μόνο « στον ηλεκτρονικό

πόλεμο του κυβερνοχώρου».

Είπε

ψέματα.

Τα

επίσημα αμυντικά έγγραφα των ΗΠΑ και

του ΝΑΤΟ που αναλύθηκαν

από το INSURGE

INTELLIGENCE αποκαλύπτουν

ότι οι δυτικές κυβερνήσεις σχεδιάζουν

ήδη να αναπτύξουν αυτόνομα οπλικά

συστήματα με την ικανότητα να λαμβάνουν

αποφάσεις για θανατηφόρα χτυπήματα -

και ότι τέτοια συστήματα, στο μέλλον,

αναμένεται ακόμη και να λάβουν αποφάσεις

για το ποιά επίπεδα" παράπλευρων

απωλειών" είναι αποδεκτά .

Πίσω από τις δημόσιες συνομιλίες, ένας μυστικός αγώνας όπλων

Οι

προσπάθειες για τη δημιουργία αυτόνομων

δολοφονικών ρομπότ έχουν εξελιχθεί

κατά την τελευταία δεκαετία, αλλά έχουν

φανεί στο προσκήνιο φέτος.

Μια

διάσκεψη του Συνδέσμου Εθνικής

Βιομηχανικής Άμυνας (NDIA) για τις

Δυνατότητες Επίγειας Ρομποτικής τον

Μάρτιο, φιλοξένησε κυβερνητικούς

αξιωματούχους και ηγέτες της βιομηχανίας,

επιβεβαιώνοντας ότι το Πεντάγωνο

αναπτύσσει ομάδες ρομπότ που θα μπορούν

να χρησιμοποιήσουν θανατηφόρα δύναμη

χωρίς ανθρώπινο χειρισμό.

Τον

Απρίλιο, κυβερνητικοί εκπρόσωποι και

διεθνείς ΜΚΟ συνεδρίασαν

στα Ηνωμένα Έθνη στη Γενεύη για να

συζητήσουν τα νομικά και ηθικά ζητήματα

σχετικά

με τα

θανατηφόρα αυτόνομα όπλα (lethal autonomous

weapon systems -LAWS).

Εκείνο

το μήνα, η βρετανική κυβέρνηση ξεκίνησε

μια κοινοβουλευτική έρευνα για τη

ρομποτική και την τεχνητή νοημοσύνη. Και

στις

αρχές Μαΐου,

το Γραφείο Επιστήμης και Τεχνολογίας

του Λευκού Οίκου ανακοίνωσε μια σειρά

δημόσιων workshops

σχετικά με τις ευρείες κοινωνικές και

οικονομικές επιπτώσεις της τεχνητής

νοημοσύνης.

Προτότυπα ρομπότ-εξολοθρευτές;

Τα

περισσότερα ΜΜΕ έχουν αναφέρει το

γεγονός ότι έως τώρα οι κυβερνήσεις δεν

έχουν αποκλείσει την μακροπρόθεσμη

πιθανότητα, ότι ευφυή ρομπότ ενδέχεται

να εξουσιοδοτηθούν ώστε να λαμβάνουν

αυτόνομες αποφάσεις θανάτωσης ανθρώπινων

στόχων.

Ωστόσο,

σε αντίθεση με τον ισχυρισμό του Robert

Work, οι ενεργές ερευνητικές και αναπτυξιακές

προσπάθειες για διερεύνηση αυτής της

δυνατότητας έχουν ήδη ξεκινήσει. Τα

σχέδια μπορούν να αντληθούν από πολλά

μη απόρρητα έγγραφα του Πενταγώνου

στο δημόσιο

αρχείο και έχουν περάσει απαρατήρητα,

μέχρι τώρα.

Μεταξύ

αυτών είναι ένα έγγραφο που κυκλοφόρησε

τον Φεβρουάριο του 2016 από την Κοινότητα

Ενδιαφέροντος Ανθρωπίνων Συστημάτων

του Πενταγώνου (Human Systems Community of

Interest = HSCOI).

Το

έγγραφο δείχνει όχι μόνο ότι το Πεντάγωνο

ενεργά δημιουργεί θανατηφόρα αυτόνομα

οπλικά συστήματα, αλλά ότι ένα κρίσιμο

συστατικό της διαδικασίας λήψης αποφάσεων

αυτων των ρομποτικών συστημάτων, θα

περιλαμβάνει πολύπλοκα μοντέλα Big Data,

τα οποία θα αντλούν δεδομένα και από

τις δημόσιες κοινοποιήσεις των μέσων

κοινωνικής δικτύωσης.

Ρομπότ που σκοτώνουν "σαν άνθρωποι"

Το

HSCOI είναι ένα ελάχιστα γνωστό δίκτυο

έρευνας και ανάπτυξης πολλαπλών

οργανισμών και προέρχεται από το

Υπουργείο Άμυνας (Office of the Secretary of Defense

= OSD), το οποίο λειτουργεί ως κεντρικός

κόμβος για μια τεράστια πληθώρα

επιστημονικών και τεχνολογικών εργασιών,

δια μέσω των στρατιωτικών και μυστικών

υπηρεσιών των ΗΠΑ.

Το

έγγραφο είναι μια παρουσίαση 53 σελίδων

που προετοιμάστηκε από τον πρόεδρο της

HSCOI, τον Δρ John Tangney, ο οποίος είναι

Διευθυντής του Τμήματος Ανθρωπίνων και

Βιομηχανικών Συστημάτων του Γραφείου

Ναυτικής Έρευνας. Με τίτλο Human Road Roadmap

Review , οι διαφάνειες

παρουσιάστηκαν στο Συνέδριο Ανθρώπινων

Συστημάτων της NDIA τον Φεβρουάριο.

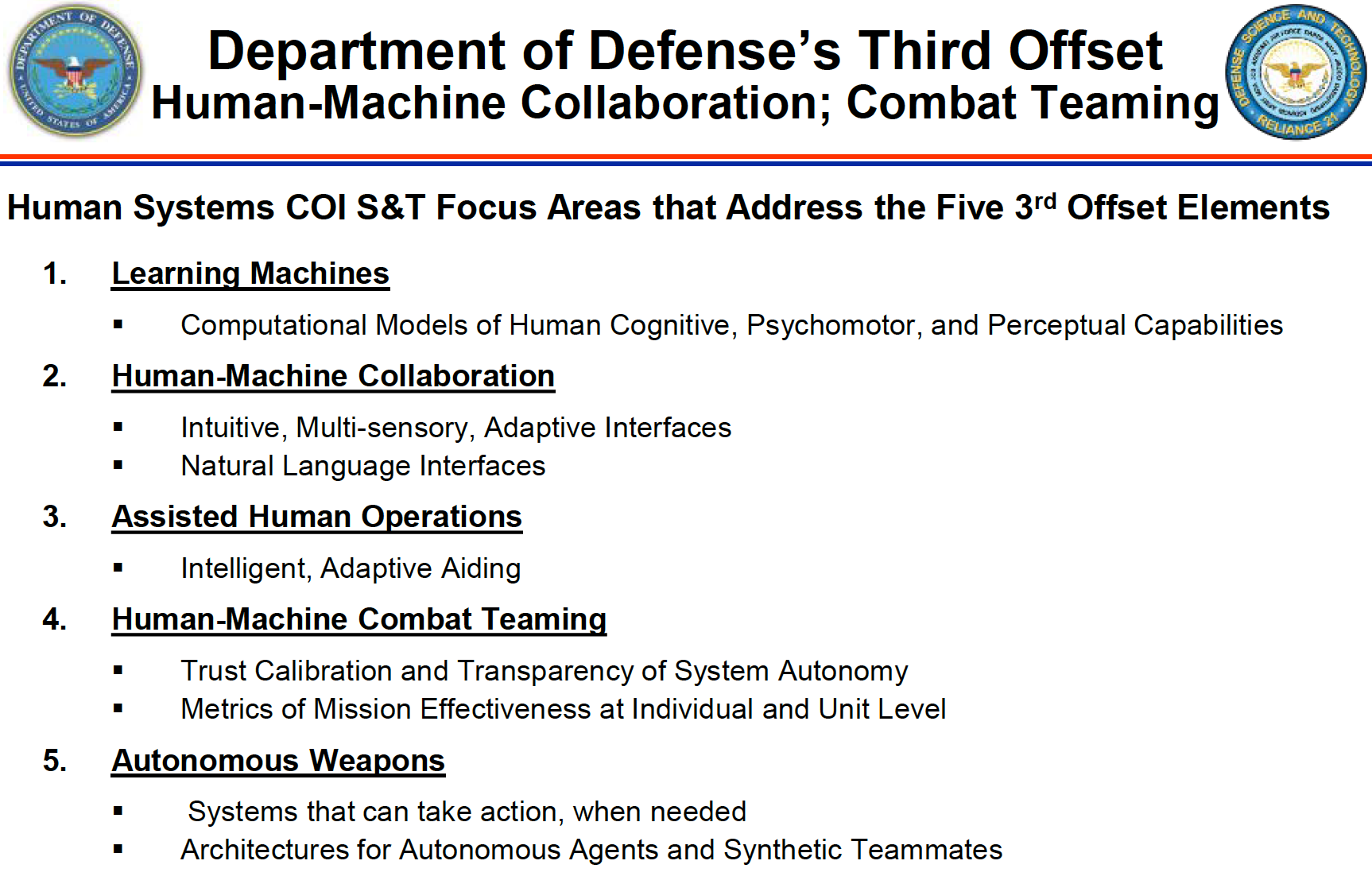

Το

έγγραφο αναφέρει ότι ένα από τα πέντε

«δομικά στοιχεία» του προγράμματος

“Ανθρώπινα Συστήματα” είναι να

κάνει «αυτόνομα σκληραγωγημένα όπλα,

ικανά μέσω δικτύου να λειτουργούν σε

ένα μελλοντικό περιβάλλον ηλεκτρονικού

κυβερνοπολέμου». Αυτό θα επέτρεπε

«συνεργατικές έννοιες όπλων σε

περιβάλλοντα που αρνούνται την

επικοινωνία».

Αλλά

στη συνέχεια το έγγραφο προχωρά περαιτέρω,

προσδιορίζοντας τους "τομείς εστίασης"

για την ανάπτυξη της επιστήμης και της

τεχνολογίας ως "Αυτόνομα όπλα:

Συστήματα που μπορούν να αναλάβουν

δράση, όταν χρειάζεται", και

"Αρχιτεκτονικές για αυτόνομους

πράκτορες και συνθετικούς

συνεργάτες".

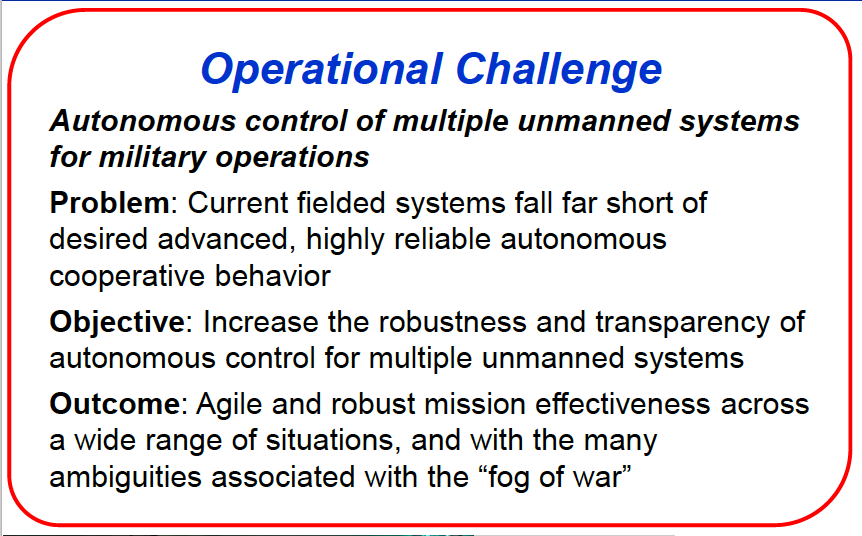

Τελικός

στόχος είναι η δημιουργία

«αυτόνομου ελέγχου πολλαπλών μη

επανδρωμένων συστημάτων για

στρατιωτικές επιχειρήσεις».

Τέτοια

αυτόνομα συστήματα πρέπει να είναι

ικανά να επιλέγουν και να εμπλέκουν

στόχους από μόνα τους - με τον ανθρώπινο

«έλεγχο» να ελαχιστοποιείται δραστικά

ώστε να επιβεβαιώνεται ότι η επιχείρηση

παραμένει εντός των παραμέτρων της

«πρόθεσης» του Διοικητή.

Το

έγγραφο δηλώνει ρητά ότι αυτά τα νέα

αυτόνομα οπλίκα συστήματα θα πρέπει να

μπορούν να ανταποκρίνονται σε απειλές

χωρίς ανθρώπινη συμμετοχή, αλλά με τρόπο

που προσομοιώνει την ανθρώπινη συμπεριφορά

και γνώση.

Το

πρόγραμμα HSCOI του υπουργείου Άμυνας

πρέπει να «γεφυρώσει το χάσμα μεταξύ

προσομοιώσεων ανθρώπινης γνώσης υψηλής

πιστότητας δοκιμασμένης σε εργαστηριακές

δοκιμές και σε σύνθετα, δυναμικά

περιβάλλοντα».

Αναφερόμενο

στους «Μηχανισμούς Γνωστικής Επεξεργασίας»

των αυτόνομων συστημάτων, το έγγραφο

τονίζει την ανάγκη για:

«Πιο

ισχυρούς, έγκυρους και ολοκληρωμένους

μηχανισμούς που επιτρέπουν εποικοδομητικούς

πράκτορες που πραγματικά σκέφτονται

και ενεργούν σαν τους ανθρώπους».

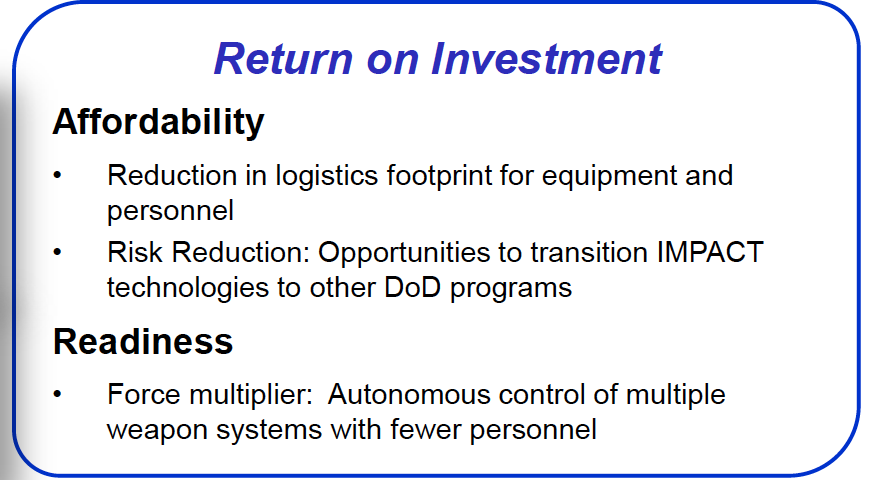

Ο

απώτερος στόχος του Πενταγώνου είναι

να αναπτύξει τον «Αυτόνομο έλεγχο

πολλαπλών οπλικών συστημάτων με λιγότερο

ανθρώπινο προσωπικό» ως «πολλαπλασιαστή

ισχύος».

Τα

νέα συστήματα πρέπει να παρουσιάζουν

«πολύ αξιόπιστη αυτόνομη συνεργατική

συμπεριφορά» για να επιτρέπουν την

«ευέλικτη και ισχυρή αποτελεσματικότητα

της αποστολής σε ένα ευρύ φάσμα καταστάσεων

και με τις πολλές ασάφειες που σχετίζονται

με την « ομίχλη του πολέμου »."

Ανάσταίνοντας το human terrain

Το

HSCOI αποτελείται από ανώτερους αξιωματούχους

από τον αμερικανικό στρατό, το ναυτικό,

τους πεζοναύτες, την πολεμική αεροπορία,

την DARPA και εποπτεύεται από τον

υφυπουργό Άμυνας, υπεύθυνο Έρευνας &

Μηχανικής και τον υφυπουργό Άμυνας,

υπεύθυνο Υγείονομικών θεμάτων.

Το

έργο της HSCOI προχωρά πολύ περισσότερο

από τη δημιουργία αυτόνομων οπλικών

συστημάτων. Ένα αναπόσπαστο μέρος

αυτού, είναι η ταυτόχρονη ανάπτυξη

διεπαφών ανθρώπου-μηχανής και προγνωστικών

αναλυτικών στοιχείων.

Το

τελευταίο περιλαμβάνει αυτό που ένα

φυλλάδιο της HSCOI για τη βιομηχανία

τεχνολογίας ονόματι «Προκλήσεις,

Ευκαιρίες και Μελλοντικές Προσπάθειες»,

περιγράφει ότι δημιουργεί «μοντέλα

πρόβλεψης απειλών με κοινωνική βάση»

ως μέρος της «ανθρώπινης δραστηριότητας

ΝΠΑ( ISR)».

Αυτό

είναι αρτικόλεξο για τις λέξεις

“νοημοσύνη”, “παρακολούθηση” και

“αναγνώριση” ενός πληθυσμού σε μια

«περιοχή ενδιαφέροντος», συλλέγοντας

και αναλύοντας δεδομένα σχετικά

με τις συμπεριφορές, τον πολιτισμό, την

κοινωνική δομή, τα δίκτυα, τις σχέσεις,

τα κίνητρα, την πρόθεση, τις ευαισθησίες

και τις δυνατότητες μιας ανθρώπινης

ομάδας.

Η

ιδέα, σύμφωνα με το φυλλάδιο, είναι να

συγκεντρωθούν δεδομένα ανοιχτού κώδικα

από ένα ευρύ φάσμα, συμπεριλαμβανομένων

των πηγών κοινωνικών μέσων δικτύωσης,

σε μια ενιαία αναλυτική διεπαφή που

μπορεί να «εμφανίσει

γνώση πεποιθήσεων, συμπεριφορών και

τάσεων που δίνουν κίνητρα σε αβέβαια

περιβάλλοντα. Να χρησιμοποιήσει αυτή

τη γνώση για τη δημιουργία πορείας

δράσης προς επίτευξη του στόχου του

Διοικητή και προς ελαχιστοποιηση των

ακούσιων συνεπειών,...[και] να κατασκευάσει

μοντέλα ώστε να επιτραπούν ακριβείς

προγνώσεις των προβλεπόμενων συμβάντων.

"

Το έγγραφο

« Human

Systems Roadmap Review»

από τον Φεβρουάριο του 2016 δείχνει ότι

αυτός ο τομέας ανάπτυξης αποτελεί

κληρονομιά του αμφιλεγόμενου προγράμματος

«ανθρώπινο έδαφος –

human terrain»

του Πενταγώνου.

Το

Human Terrain System (HTS) ήταν ένα πρόγραμμα

Εκπαίδευσης και Διδασκαλίας του Στρατού

των ΗΠΑ ( TRADOC) που δημιουργήθηκε το 2006,

και το οποίο τοποθέτησε κοινωνικούς

επιστήμονες στο πεδίο της μάχης, για να

αυξήσει τις επιχειρήσεις ανταρσίας σε

σημεία όπως το Ιράκ και το Αφγανιστάν.

Η

ιδέα ήταν να χρησιμοποιηθούν οι

κοινωνιολόγοι και οι πολιτιστικοί

ανθρωπολόγοι για να παράσχουν στο στρατό

των ΗΠΑ πληροφορίες για τους τοπικούς

πληθυσμούς ώστε να διευκολυνθούν οι

πολεμικές επιχειρήσεις - με άλλα λόγια,

οι κοινωνικές επιστήμες να χρησιμοποιηθούν

ως όπλα.

Το

πρόγραμμα των 725 εκατομμυρίων

δολαρίων τερματίστηκε τον

Σεπτέμβριο του 2014 μετά την αυξανόμενη

διαμάχη για την απόλυτη ανικανότητά

του.

Το

πρόγραμμα HSCOI που το αντικαθιστά

περιλαμβάνει κοινωνικές επιστήμες,

αλλά η μεγαλύτερη έμφαση δίνεται τώρα

στο συνδυασμό τους με προγνωστικά

υπολογιστικά μοντέλα που βασίζονται

σε Big Data. Το φυλλάδιο θέτει τον

προβλεπόμενο προϋπολογισμό για το νέο

έργο ανθρώπινων συστημάτων σε 450

εκατομμύρια δολλάρια.

Η Επισκόπηση

του Χάρτη για

τα Ανθρώπινα

Συστήματα του

Πενταγώνου καταδεικνύει ότι αντί να

εξαληφθεί, το πρότυπο HTS έχει αναβαθμιστεί

ως μέρος ενός ευρύτερου προγράμματος

πολλαπλών υπηρεσιών που περιλαμβάνει

την ενσωμάτωση αναλυτικών στοιχείων

Big Data με διεπαφές ανθρώπου-μηχανής και

τελικά, αυτόνομα οπλικά συστήματα.

Η νέα επιστήμη παρατήρησης των κοινωνικών μέσων δικτύωσης, “μέσω γυάλινης σφαίρας”

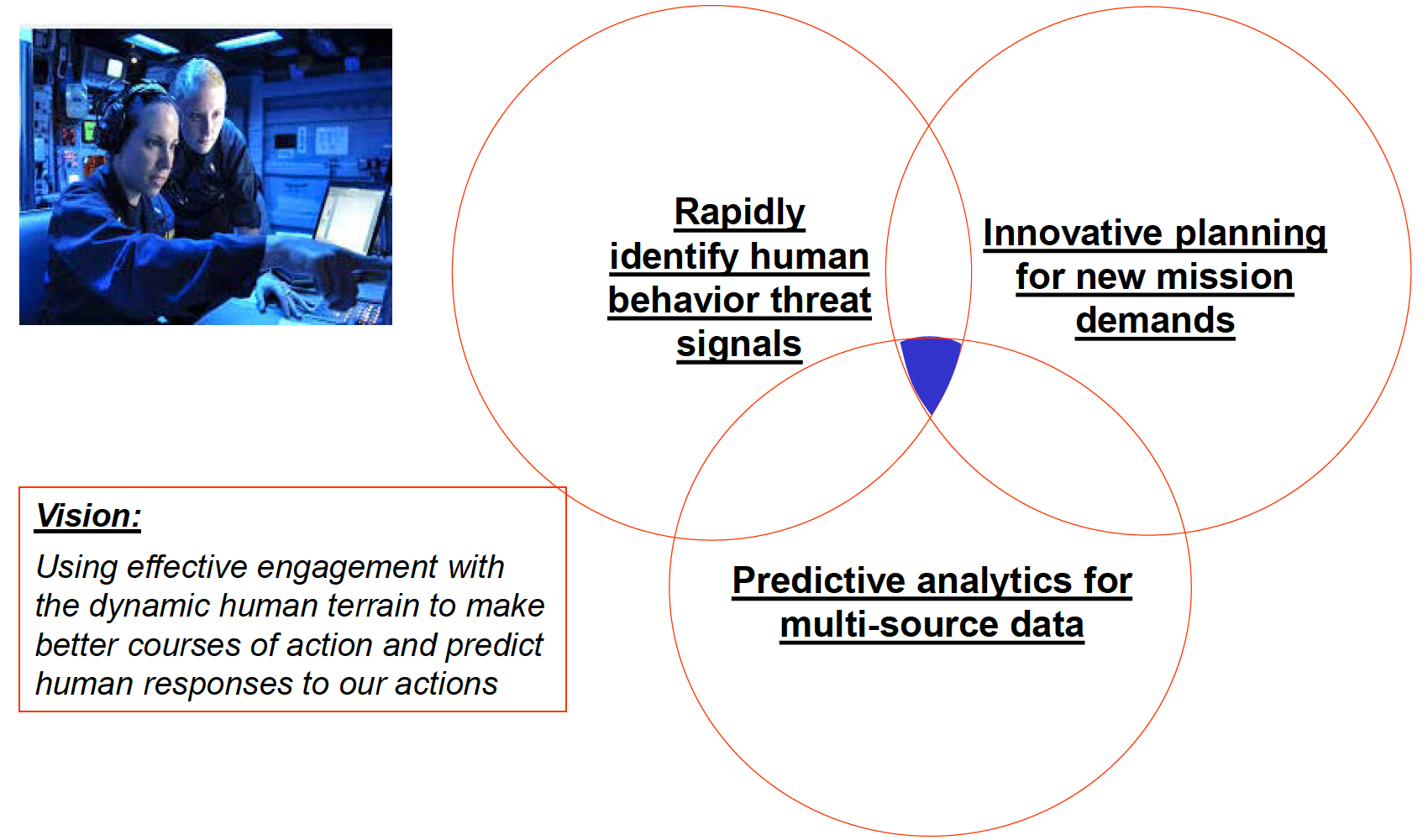

Ο

χάρτης ανθρώπινων συστημάτων του 2016

εξηγεί ότι το «όραμα» του Πενταγώνου

είναι να χρησιμοποιήσει την «αποτελεσματική

δέσμευση με το δυναμικό human

terrain για να δημιουργήσει

καλύτερες πορείες δράσης και να προβλέψει

τις ανθρώπινες αντιδρασεις στις ενέργειές

μας» με βάση την «προγνωστική ανάλυση

για δεδομένα από πολλαπλές πηγές».

Είναι

οι εικονιζόμενοι “στρωτιώτες”

άνθρωποι...ή στην πραγματικότητα πρόκειται

περί ανθρωποειδών δολοφονικών ρομπότ;

Σε

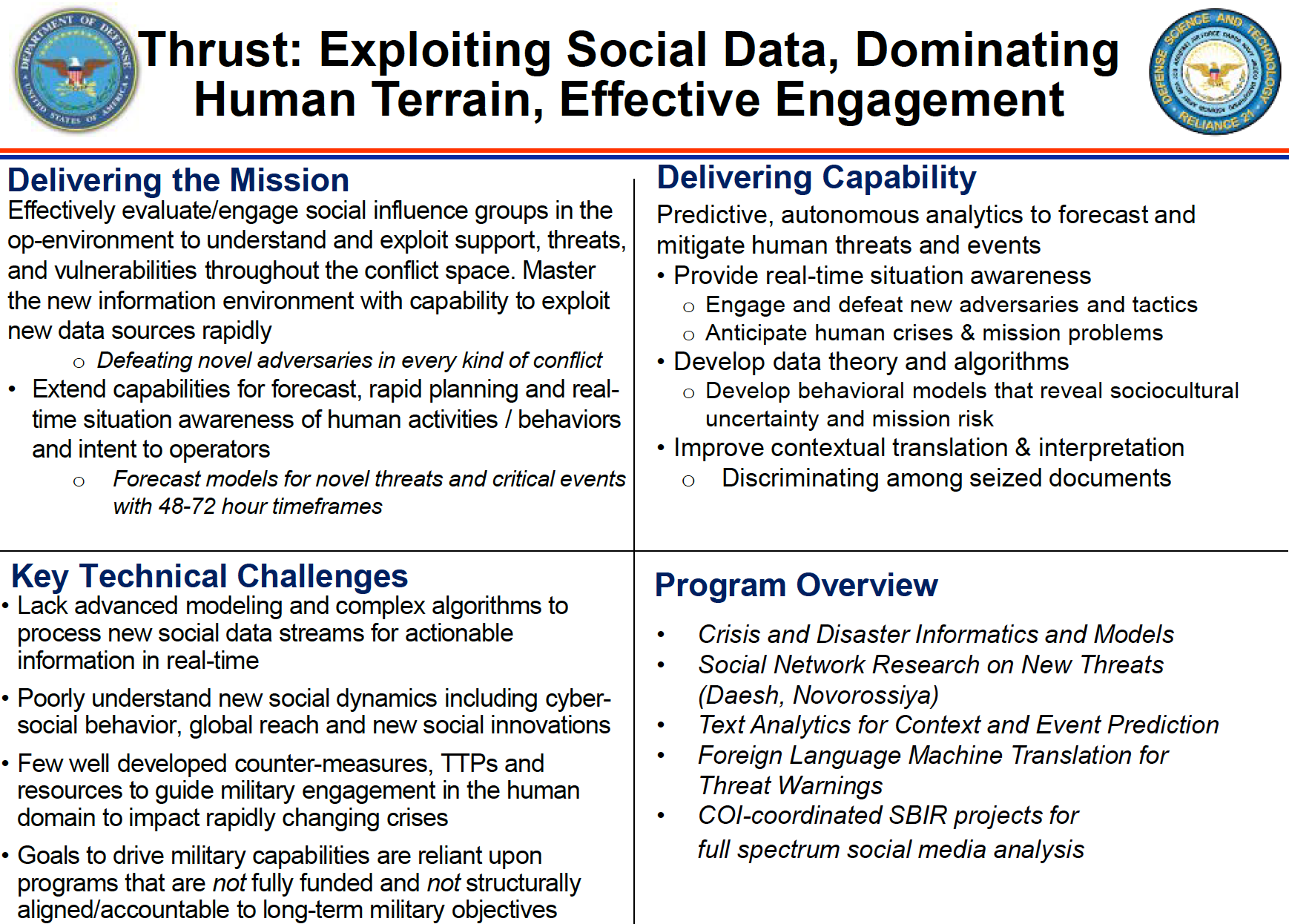

μια διαφάνεια με τίτλο, «Εκμετάλλευση

Κοινωνικών Δεδομένων, Κυριαρχώντας στο

Human Terrain,

Αποτελεσματική Δέσμευση», βλέπουμε ότι

το έγγραφο παρέχει περισσότερες

λεπτομέρειες σχετικά με τους στόχους

του Πενταγώνου:

«Αποτελεσματική

αξιολόγηση / δέσμευση ομάδων κοινωνικής

επιρροής στο op-περιβάλλον για την

κατανόηση και εκμετάλλευση υποστήριξης,

απειλών και τρωτών σημείων σε όλο τον

χώρο των συγκρούσεων. Κατάκτηση του

νέου περιβάλλοντος πληροφοριών με

δυνατότητα γρήγορης εκμετάλλευσης νέων

πηγών δεδομένων. "

Το

Πεντάγωνο θέλει να αντλήσει από τις

τεράστιες αποθήκες δεδομένων ανοιχτού

κώδικα που μπορούν να υποστηρίξουν

«προγνωστικά, αυτόνομα αναλυτικά

στοιχεία για την πρόβλεψη και τον

μετριασμό των ανθρώπινων απειλών και

συμβάντων».

Αυτό

σημαίνει όχι απλώς την ανάπτυξη "μοντέλων

συμπεριφοράς που αποκαλύπτουν την

κοινωνική και πολιτισμική αβεβαιότητα

και το ρίσκο της αποστολής", αλλά και

τη δημιουργία "μοντέλων πρόβλεψης

για νέες απειλές και κρίσιμα γεγονότα

σε χρονικό πλαίσιο 48-72 ωρών", αλλά

ακόμη και την καθιέρωση τεχνολογίας

που θα χρησιμοποιεί τέτοια δεδομένα

για " επίγνωση της κατάστασης σε

πραγματικό χρόνο.”

Σύμφωνα

με το έγγραφο, η «ανάλυση των κοινωνικών

μέσων δικτύωσης σε πλήρες φάσμα» θα

διαδραματίσει τεράστιο ρόλο σε αυτό το

μοντέλο, θα υποστηρίξει «ασύμετρο

πόλεμο, αποστολές πληροφοριών και

στρατηγικές επικοινωνίες».

Αυτό

αναλύεται περαιτέρω σε τρεις βασικούς

τομείς:

"Προγνωστικά

αναλυτικά μέσα πολυμέσων. Ανάκτηση

κειμένου και βίντεο βάσει

περιεχομένου. Εκμετάλλευση των

κοινωνικών μέσων για πληροφορίες. "

Το

έγγραφο αναφέρεται στη χρήση των

δεδομένων από τα κοινωνικά μέσα δικτύωσης

για πρόβλεψη μελλοντικών απειλών και,

σε αυτή τη βάση, θα αναπτύσσονται αυτόματα

προτάσεις για ένα «σχέδιο δράσης» (CoA).

Υπό

τον τίτλο «Ανάλυση αδύναμου σήματος

και ανάλυση των κοινωνικών δικτύων για

την πρόβλεψη απειλών», το Πεντάγωνο

υπογραμμίζει την ανάγκη για :

"Ανάπτυξη

σε πραγματικό χρόνο της κατανόησης του

αβέβαιου περιβάλλοντος με εργαλεία

χαμηλού κόστους που είναι εύκολο να

εκπαιδεύτούν, να μειώσουν το φόρτο

εργασίας των αναλυτών και να ενημερώσουν

την επιλογή / ανάλυση του σχεδίου δράσης."

Με

άλλα λόγια, η ανθρώπινη συμβολή στην

ανάπτυξη του σχεδίου δράσης «επιλογή

/ ανάλυση», πρέπει να μειωθεί όλο και

περισσότερο και να αντικατασταθεί με

αυτοματοποιημένα προγνωστικά αναλυτικά

μοντέλα που βασίζονται εκτενώς σε

δεδομένα κοινωνικών μέσων δικτύωσης.

Αυτό

μπορεί ακόμη και να χρησιμοποιηθεί για

να ενημερώσει τους στρατιώτες για

απειλές σε πραγματικό χρόνο χρησιμοποιώντας

επαυξημένη

πραγματικότητα κατά τη

διάρκεια επιχειρήσεων. Το έγγραφο

αναφέρεται στη "Συγχώνευση των

Κοινωνικών Μέσων Δικτύωσης για να

προειδοποιεί τους τακτικούς στρατιώτες"

και στην "Αναγνώριση του προσώπου

ενδιαφέροντος και τις σχετικές του

σχέσεις".

Η

ιδέα είναι να προσδιοριστούν οι πιθανοί

στόχοι - «πρόσωπα ενδιαφέροντος» - και

τα δίκτυά επαφών τους, σε πραγματικό

χρόνο, χρησιμοποιώντας τα δεδομένα των

κοινωνικών μέσων δικτύωσης ως

«πληροφοριοδότες».

Ανθρώπινος έλεγχος με νόημα χωρίς ανθρώπους

Τόσο

οι ΗΠΑ όσο και η Βρετανία προσπαθούν

γρήγορα να επαναπροσδιορίσουν τον

«ανθρώπινο έλεγχο» και την «ανθρώπινη

πρόθεση», στο πλαίσιο των αυτόνομων

συστημάτων.

Μεταξύ

των προβλημάτων που προέκυψαν στις

συναντήσεις του ΟΗΕ τον Απρίλιο είναι

η τάση να υποβαθμίζονται οι παράμετροι

που θα επέτρεπαν την περιγραφή ενός

αυτόνομου οπλικού συστήματος ως

συνδεδεμένου με «ουσιαστικό» ανθρώπινο

έλεγχο.

Ένα

ξεχωριστό έγγραφο του Πενταγώνου με

ημερομηνία Μαρτίου 2016 ( που είναι ένα

σύνολο διαφανειών παρουσίασης για το

Συνέδριο IEEE του ιδίου μήνα για γνωστικές

μεθόδους σε κατάσταση συνειδητοποίησης

και υποστήριξης αποφάσεων) επιμένει

ότι η πολιτική του υπουργείου Άμυνας

είναι να διασφαλίσει ότι τα αυτόνομα

οπλικά συστήματα τελικά λειτουργούν

υπό την επίβλεψη του ανθρώπου:

"[Τα]

κύρια οφέλη των αυτόνομων δυνατοτήτων

είναι η επέκταση και η συμπλήρωση της

ανθρώπινης απόδοσης, όχι απαραίτητα η

άμεση αντικατάσταση των ανθρώπων."

Δυστυχώς,

υπάρχει ένα «αλλά».

Το

έγγραφο του Μαρτίου, ονόματι “Αυτόνομοι

Ορίζοντες:Αυτονομία Συστήματος στην

Πολεμική Αεροπορία( Autonomous

Horizons: System Autonomy in the Air Force) ,

συντάχθηκε από τον Δρ. Greg Zacharias, επικεφαλής

επιστήμονα της Πολεμικής Αεροπορίας

των ΗΠΑ. Το συνέδριο του IEEE όπου

παρουσιάστηκε, χρηματοδοτήθηκε από δύο

κορυφαίους εργολάβους του υπουργείου

άμυνας, την Lockheed Martin και την United

Technologies Corporation, μεταξύ άλλων.

Περαιτέρω

αποσπάσματα του εγγράφου αποκαλύπτουν:

«Οι

αυτόνομες αποφάσεις μπορούν να οδηγήσουν

σε ενέργειες για τις οποίες θα μετανοιώσουμε

πικρά , ιδιαιτέρως σε αβέβαια περιβάλλοντα».

Συγκεκριμένα,

το έγγραφο παρατηρεί:

«Κάποια

δραστηριότητα του υπουργείου άμυνας,

όπως η εφαρμογή ισχύος, θα συμβεί σε

περίπλοκα, απρόβλεπτα και αμφισβητούμενα

περιβάλλοντα. Ο κίνδυνος είναι υψηλός.

"

Η

υποτιθέμενη λύση, είναι να σχεδιάσουμε

μηχανές που βασικά σκέφτονται, μαθαίνουν

και επιλύουν προβλήματα όπως οι

άνθρωποι. Ένα αυτόνομο σύστημα

τεχνητής νοημοσύνης θα πρέπει «να είναι

σύμφωνο με τον τρόπο με τον οποίο οι

άνθρωποι αναλύουν το πρόβλημα» και να

καθοδηγείται από «βοηθητικές /

αυτοματοποιημένες δια δικασίες

διαχείρισης γνώσεων σύμφωνα με τον

τρόπο με τον οποίο οι άνθρωποι επιλύουν

το πρόβλημα [sic]».

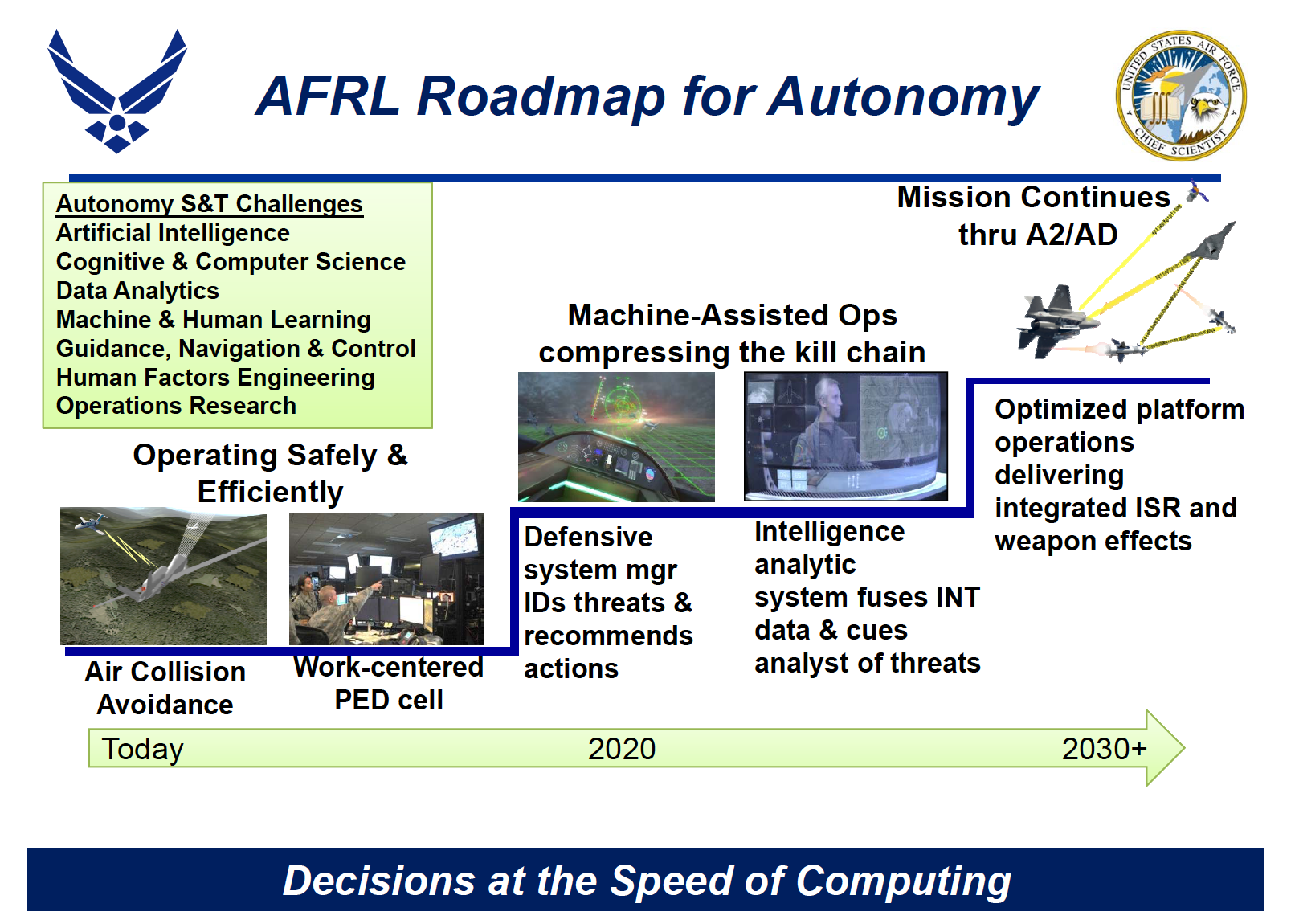

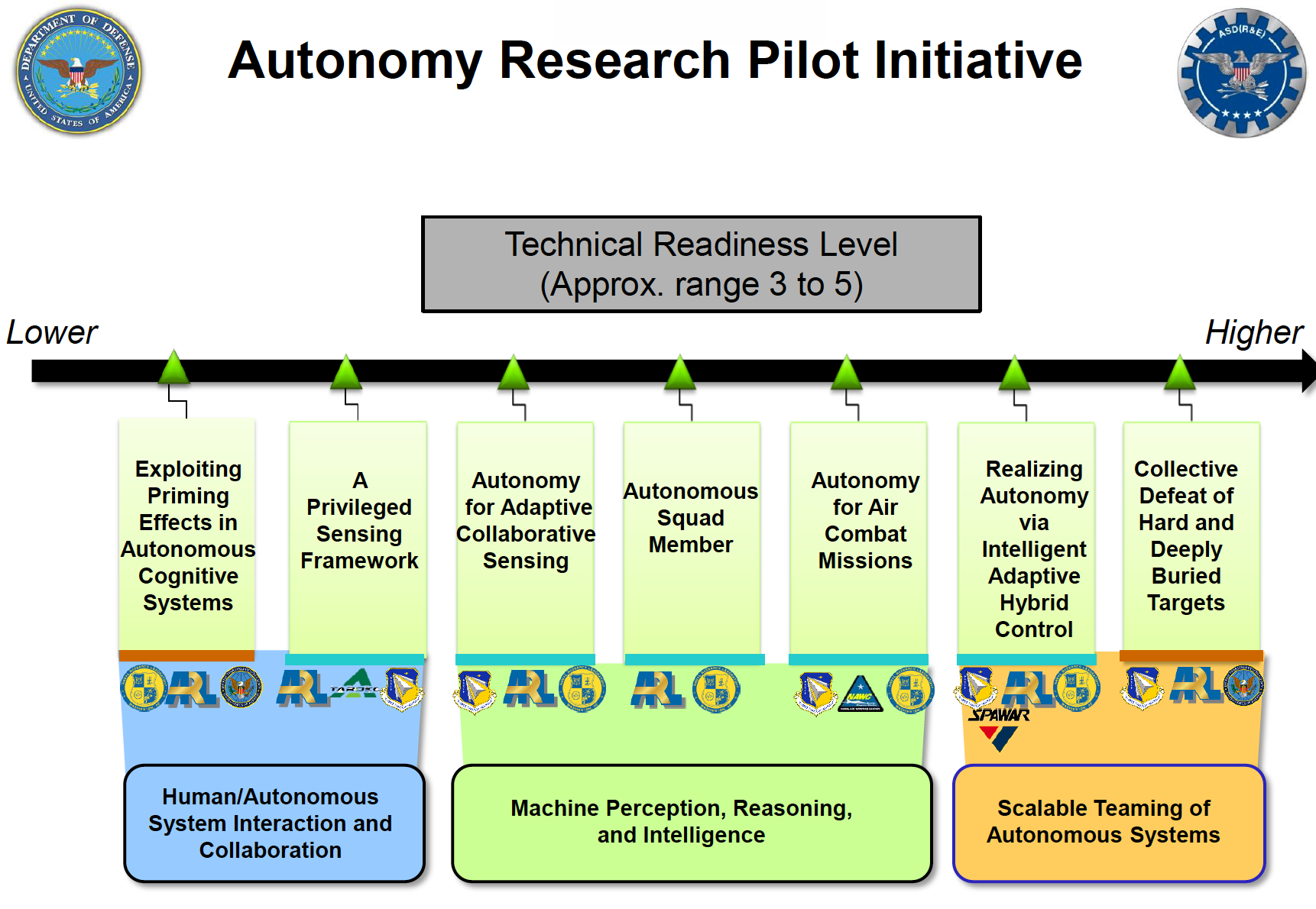

Μια

ενότητα με τίτλο «Χάρτης AFRL [Air Force

Research Laboratory -Ερευνητικού Εργαστηρίου

της Πολεμικής Αεροπορίας ] για την

αυτονομία» δείχνει πώς μέχρι το 2020, η

Πολεμική Αεροπορία των ΗΠΑ οραματίζεται

«Μηχανήματα που υποβοηθούν τη συμπίεση

της αλυσίδας θανάτωσης».

Το

κάτω μέρος της διαφάνειας αναφέρει:

"Αποφάσεις

με ταχύτητα προγραμματισμού (computing)."

Αυτή

η «αλυσίδα δολοφονίας» δύο σταδίων,

αναλύεται ως εξής: πρώτον, το «Διοικητικό

αμυντικό σύστημα αναγνωρίζει απειλές

και προτείνει ενέργειες» και δεύτερον,

«Το αναλυτικό σύστημα πληροφοριών

συγχωνεύει δεδομένα πληροφοριών και

πληροφορεί τον αναλυτή απειλών».

Σε

αυτήν τη δομή, ένα θανατηφόρο αυτόνομο

οπλικό σύστημα βασίζεται σε δεδομένα

πληροφοριών για να εντοπίσει μια απειλή,

την οποία ένας αναλυτής απλώς «αναγνωρίζει»,

προτού προτείνει «δράση».

Ο

ρόλος του αναλυτή εδώ είναι απλώς να

εγκρίνει τη δολοφονία, αλλά στην

πραγματικότητα η ουσιαστική σημασία

του ανθρώπινου ελέγχου – η αξιολόγηση

της απόφασης δολοφονίας - υποβιβάστηκε

τελικά σε μια εντελώς αυτοματοποιημένη

αναλυτική διαδικασία, σαν απλή υποχρέωση.

Μέχρι

το 2030, το έγγραφο θεωρεί ότι η συμμετοχή

του ανθρώπου σε αυτήν τη διαδικασία θα

μειωθεί ακόμη περισσότερο, στο απολύτως

ελάχιστο. Ενώ ένας ανθρώπινος χειριστής

μπορεί να διατηρείται « in

the loop» (όπως αναφέρεται

στο έγγραφο), το Πεντάγωνο προσβλέπει

σε ένα πλήρως αυτόνομο σύστημα που

αποτελείται από:

«Βελτιστοποιημένες λειτουργίες πλατφόρμας που παρέχουν ολοκληρωμένη ευφυΐα, παρακολούθηση και αναγνώριση και οπλικές ενέργειες.»

Ο

στόχος, με άλλα λόγια, είναι ένα ενιαίο

θανατηφόρο αυτόνομο οπλικό σύστημα που

συνδυάζει ανάλυση πλήρους φάσματος

όλων των δεδομένων, με «οπλικές ενέργειες»

- δηλαδή, επιλογή στόχου και εκτέλεση

του.

Το

έγγραφο καταβάλλει κάθε δυνατή προσπάθεια

να κρύψει αυτό το όραμα, με την αίσθηση

της ανθρώπινης εποπτείας να είναι πάντα

παρούσα.

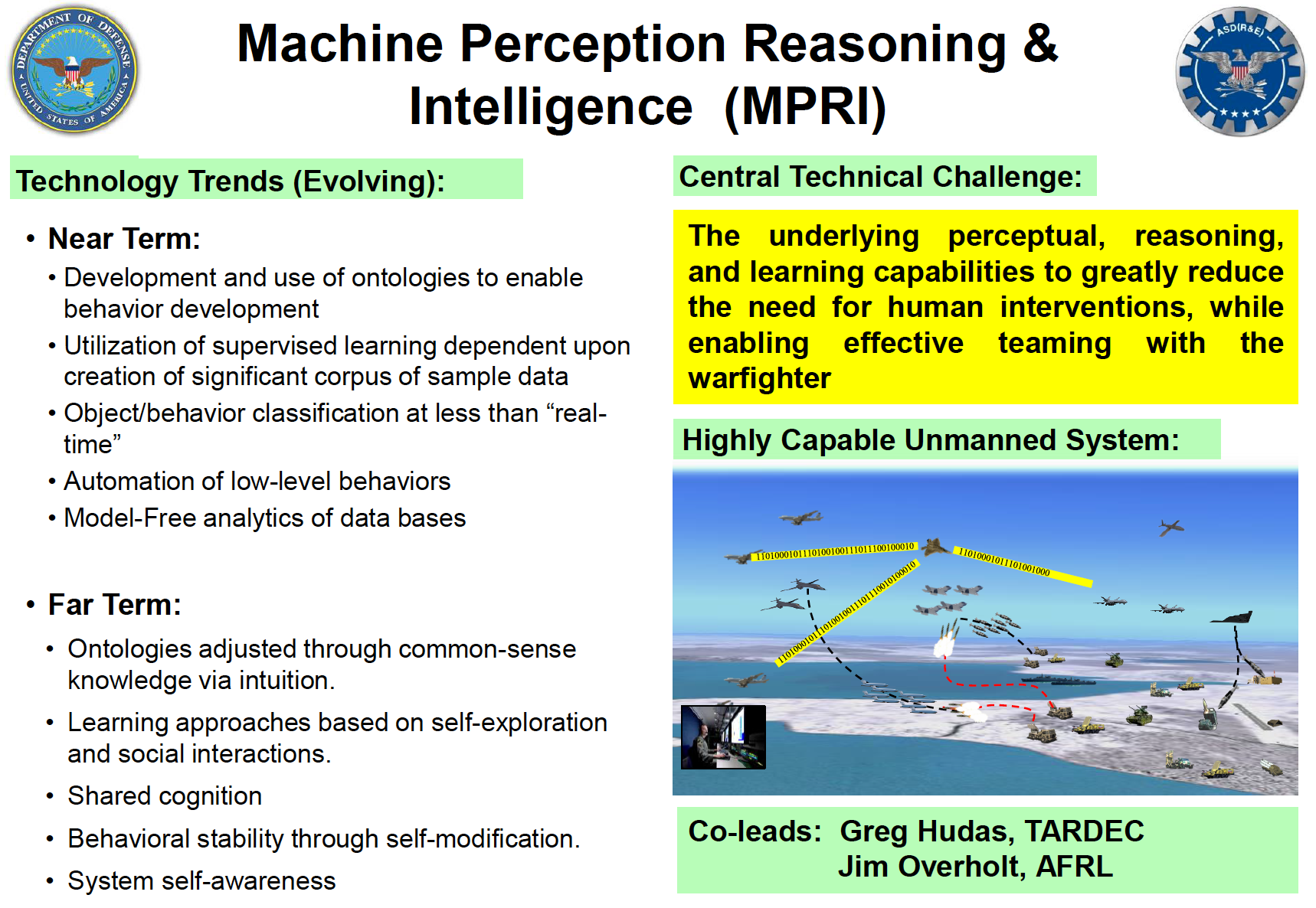

«Αυτογνωσία του συστήματος τεχνητής νοημοσύνης»

Ωστόσο,

ένας ακόμη πιο εξώφθαλμος ισχυρισμός

για τον στόχο του Πενταγώνου παρουσιάζεται

σε ένα τρίτο έγγραφο, ένα σύνολο διαφανειών

με τίτλο DoD

Autonomy Roadmap (Χάρτης Αυτονομίας του Υπουργείου

Αμύνης) που παρουσιάστηκε

ακριβώς ένα χρόνο νωρίτερα στο ΙNDIA's

Defense Tech Expo (Αμυντική έκθεση της Ινδίας).

Το

έγγραφο που συνέταξε ο Δρ. Jon Bornstein, ο

οποίος ηγείται της Αυτόνομης Κοινότητας

Ενδιαφέροντος του Υπουργείου Άμυνας

(ACOI), ξεκινά προσδιορίζοντας το περιεχόμενό

του με την προειδοποίηση: «Ούτε οι

μαχητές του πολέμου ούτε οι μηχανές δεν

είναι πραγματικά αυτόνομα».

Ωστόσο,

συνεχίζει να θέλει τους πράκτορες-μηχανές

να αναπτύξουν:

«Η αντίληψη, η συλλογιστική και η νοημοσύνη επιτρέπουν στις οντότητες να έχουν ύπαρξη, πρόθεση, σχέσεις και κατανόηση στο χώρο της μάχης, σχετικά με μια αποστολή».

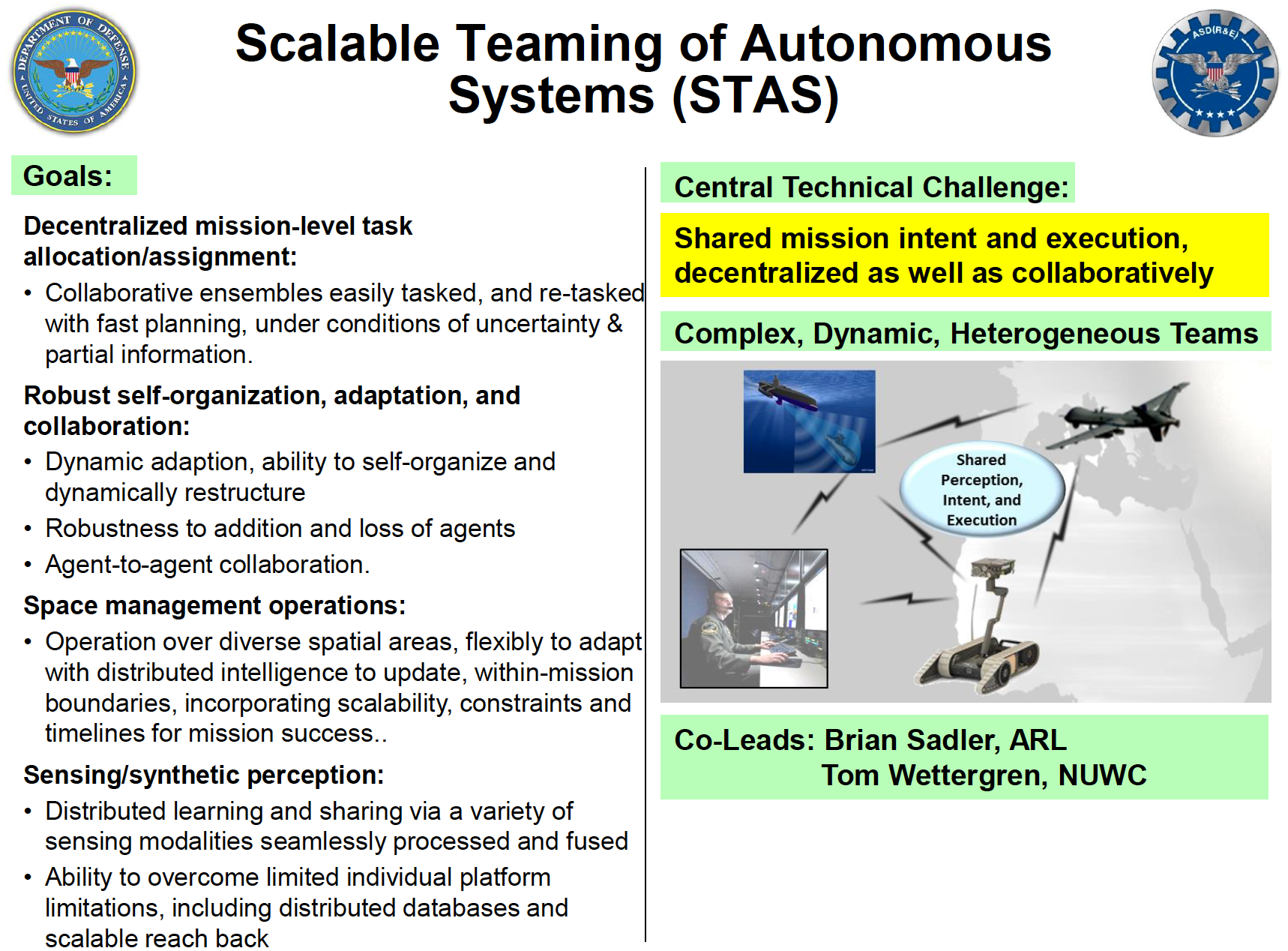

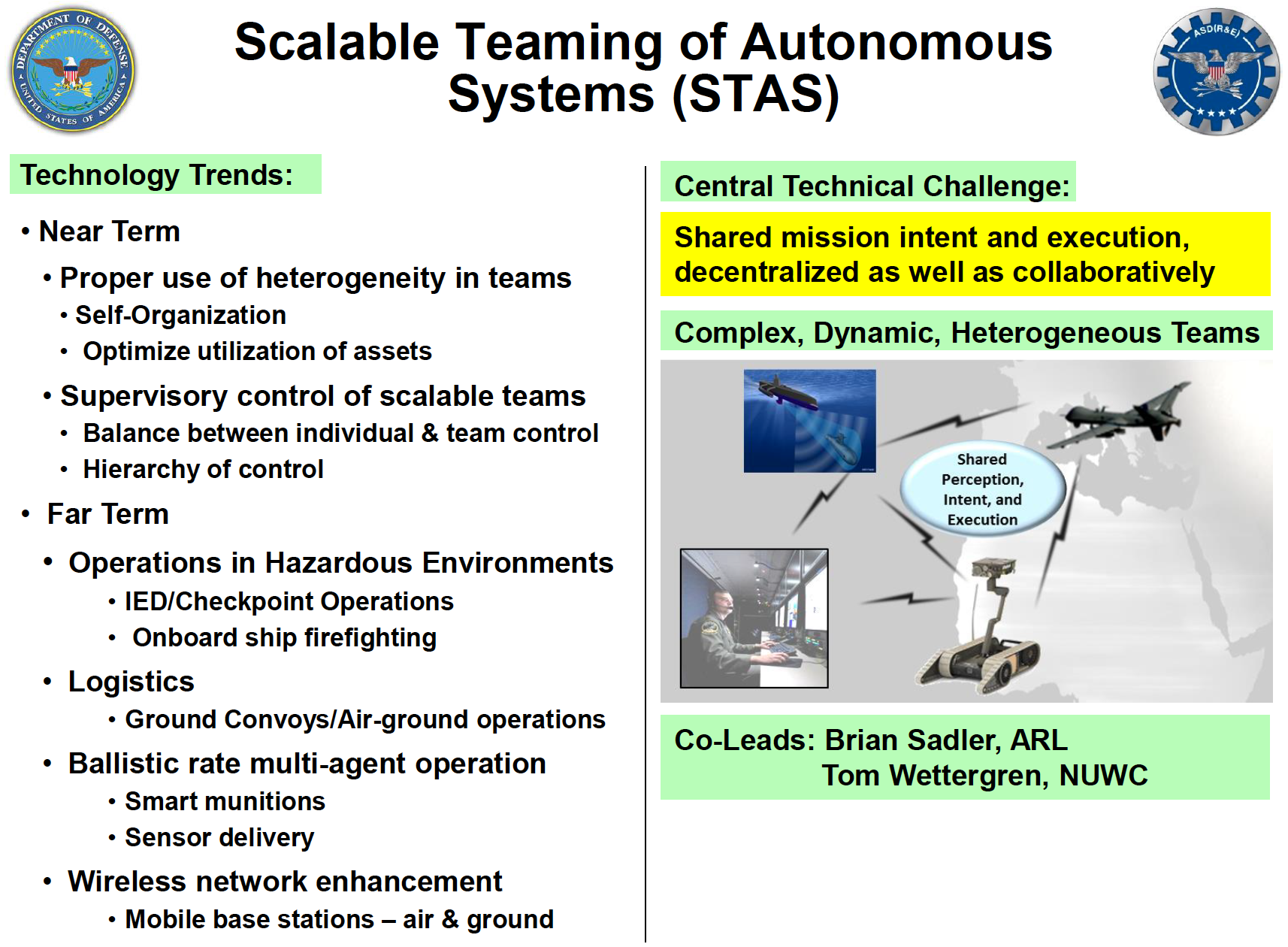

Αυτό

θα είναι το θεμέλιο για δύο τύπους

οπλικών συστημάτων: «Ανθρώπινη / Αυτόνομη

Αλληλεπίδραση Συστήματος και Συνεργασίας

(HASIC)» και «Εξελικτική Συνεργασία

Αυτόνομων Συστημάτων (STAS)».

Βραχυπρόθεσμα,

οι πράκτορες-μηχανές θα είναι σε θέση

«να αναπτύσουν συμπεριφορές με την

πάροδο του χρόνου, με βάση μια περίπλοκη

και συνεχώς μεταβαλλόμενη γνώση του

χώρου μάχης… στο πλαίσιο της αποστολής,

των βασικών γνώσεων, των προθέσεων και

των πληροφοριών από αισθητήρες».

Ωστόσο

αυτό που είναι ιδιαίτερα ανησυχητικό,

είναι το «μακρινό» όραμα του Πενταγώνου

για μηχανές-πράκτορες ως συστήματα

«αυτογνωσίας»:

"Μακροπρόθεσμα:

• Οι οντότητες (πράκτορες-μηχανές) προσαρμόζονται μέσω γνώσης της κοινής λογικής, μέσω της διαίσθησης.

• Μαθησιακές προσεγγίσεις βασισμένες σε αυτοεξερεύνηση και κοινωνικές αλληλεπιδράσεις.

• Κοινή γνώση

• Συμπεριφορική σταθερότητα μέσω αυτο-τροποποίησης.

• Αυτογνωσία συστήματος »

Σε

αυτό το πλαίσιο της «αυτογνωσίας» ενός

αυτόνομου οπλικού συστήματος, το έγγραφο

διευκρινίζει την ανάγκη, το σύστημα να

αναπτύξει αυτόνομα αποφάσεις για δράση,

και συγκεκριμένα:

«Αυτόνομα συστήματα που χρησιμοποιούν κατάλληλα εσωτερικές προσεγγίσεις σχεδιασμού που βασίζονται σε μοντέλα / διαβουλεύσεις και δράσεις / έλεγχους που βασίζονται στην ανίχνευση / αντίληψη.»

Το

Πεντάγωνο συγκεκριμένα ελπίζει να

δημιουργήσει αυτό που αποκαλεί «αξιόπιστα

αυτόνομα συστήματα», δηλαδή,

πράκτορες-μηχανές των οποίων η συμπεριφορά

και η συλλογιστική μπορούν να κατανοηθούν

πλήρως, και ως εκ τούτου να θεωρηθούν

«αξιόπιστα» από τους ανθρώπους.

«Η συνεργασία σημαίνει ότι πρέπει να υπάρχει κατανόηση και εμπιστοσύνη στις συμπεριφορές και στη λήψη αποφάσεων σε ένα εύρος συνθηκών. Η διαφάνεια των πρακτόρων-μηχανών επιτρέπει στον άνθρωπο να καταλάβει τι κάνει ο πράκτορας και γιατί. "

Για

άλλη μια φορά, αυτό είναι για να

διευκολυνθεί η διαδικασία με την οποία

οι άνθρωποι απομακρύνονται όλο και

περισσότερο από την ουσία των επιχειρήσεων.

Στο

"Μεσοπρόθεσμο" διάστημα, θα υπάρξουν

"Βελτιωμένες μέθοδοι για την κατανομή

της εξουσίας" μεταξύ ανθρώπων και

μηχανών. Στο "Μακροπρόθεσμο"

διάστημα, αυτό θα έχει εξελιχθεί σε ένα

σύστημα μηχανών που λειτουργεί αυτόνομα

με βάση την "Συνειδητοποίηση των

“προθέσεων των διοικητών "" και

της "χρήσης έμμεσων μηχανισμών

ανατροφοδότησης (feedback) ".

Αυτό

θα δημιουργήσει επιτέλους την ικανότητα

ανάπτυξης της "Κλιμακούμενης

Συνεργασίας Αυτόνομων Συστημάτων

(STAS)", χωρίς να κατευθύνεται φανερά

από ανθρώπους , στην οποία πολλαπλοί

πράκτορες-μηχανές εμφανίζουν "κοινή

αντίληψη, πρόθεση και εκτέλεση".

Ομάδες

αυτόνομων οπλικών συστημάτων θα

εμφανίζουν «Ισχυρή αυτο-οργάνωση,

προσαρμοστικότητα και συνεργασία»,

«Δυναμική προσαρμογή, ικανότητα

αυτο-οργάνωσης και δυναμική αναδιάρθρωση»

και «Συνεργασία μεταξύ πρακτόρων-μηχανών».

Παρατηρήστε

την έλλειψη ανθρώπινης συνεργασίας.

Το

«μακρινό» όραμα για τέτοια αυτόνομα

«με αυτογνωσία» οπλικά συστήματα δεν

περιορίζεται, όπως ισχυρίστηκε ο Robert

Work, στον κυβερνοχώρο ή στον ηλεκτρονικό

πόλεμο, αλλά θα περιλαμβάνει:

«Συγκοινωνίες εδάφους / Λειτουργίες εδάφους-αέρα». «Βαλλιστική λειτουργία πολλαπλών παραγόντων» "Έξυπνα πυρομαχικά."

Αυτές

οι επιχειρήσεις ενδέχεται να

πραγματοποιούνται ακόμη και σε

πυκνοκατοικημένα αστικά περιβάλλοντα

- «σε κοντινή απόσταση από άλλα επανδρωμένα

και μη επανδρωμένα συστήματα,

συμπεριλαμβανομένων πολυσύχναστων

στρατιωτικών και αστικών περιοχών».

Το

έγγραφο παραδέχεται, ωστόσο, ότι η μεγάλη

πρόκληση του Πενταγώνου είναι να

μετριάσει απρόβλεπτα περιβάλλοντα και

αναδυόμενες συμπεριφορές.

Είναι

«δύσκολο να διασφαλιστεί η σωστή

συμπεριφορά στις άπειρες περιβαλλοντικές

συνθήκες» των αυτόνομων συστημάτων και

«είναι δύσκολο να συλλάβουν επαρκώς

και να κατανοήσουν όλες τις εκούσιες

και ακούσιες συνέπειες».

Ομάδες εξολοθρευτών, με επικεφαλής ανθρώπους

Ο

Χάρτης Αυτονομίας επιβεβαιώνει σαφώς

ότι ο τελικός στόχος του Πενταγώνου

είναι να μεταβιβάσει το μεγαλύτερο

μέρος των στρατιωτικών επιχειρήσεων

σε αυτόνομες μηχανές, ικανές να προκαλέσουν

«Συλλογική ήττα σκληρών και βαθιά

θαμμένων στόχων».

Ένας

τύπος πράκτορα-μηχανής είναι η "Αυτόνομη

Ομάδα Μέλους (Στρατού)-Autonomous Squad Member

",

η οποία "Ενσωματώνει τη σημασιολογική

κατανόηση, τη συλλογιστική και την

αντίληψη της μηχανής σε ένα επίγειο

ρομποτικό σύστημα" και εμφανίζει:

"Πρώιμη

εφαρμογή ενός μοντέλου συλλογιστικής

στόχου, Αυτονομία κατευθυνόμενης από

στόχους (GDA) για να παρέχει στο ρομπότ

τη δυνατότητα αυτο-επιλογής νέων στόχων

όταν συναντά μια απρόβλεπτη κατάσταση."

Τα

ανθρώπινα μέλη της ομάδας πρέπει να

είναι σε θέση «να κατανοήσουν την

πρόθεση, την απόδοση, τα μελλοντικά

σχέδια και τη συλλογιστική διαδικασία

ενός έξυπνου πράκτορα».

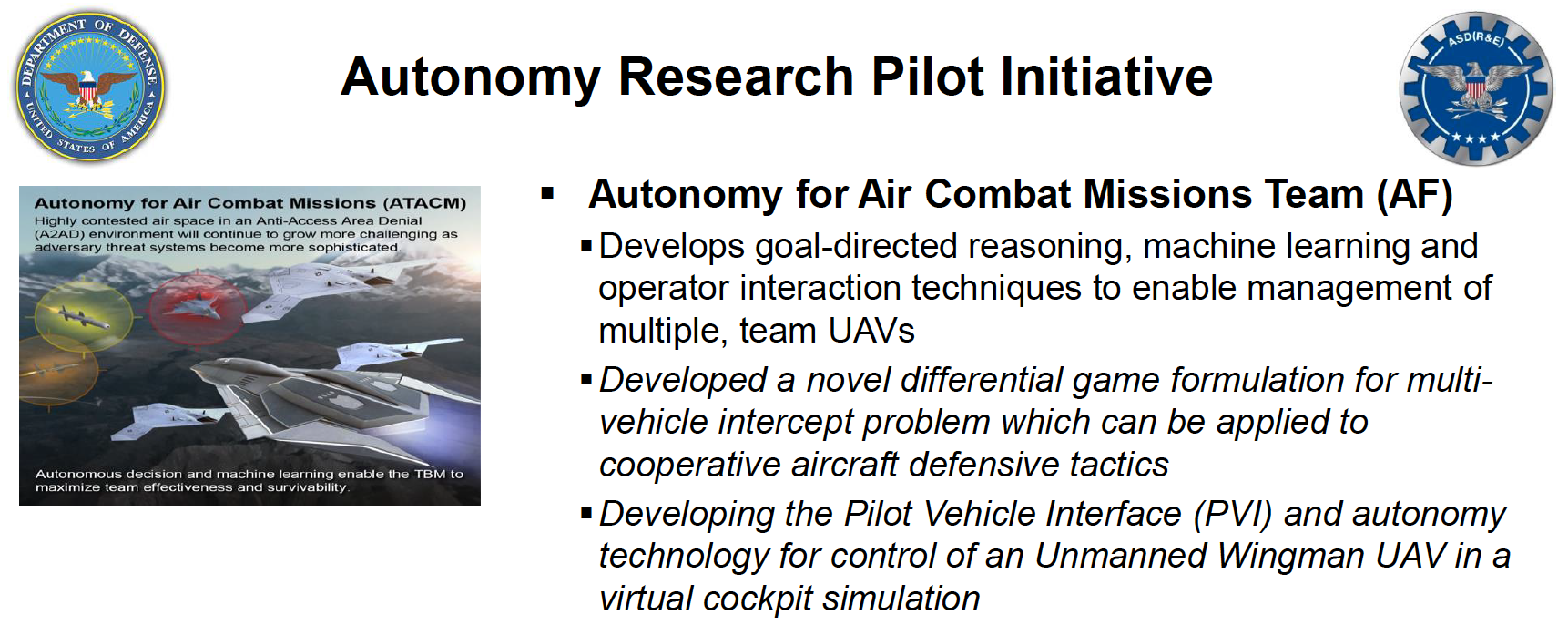

Ένας

άλλος τύπος περιγράφεται στην επικεφαλίδα,

«Autonomy for Air Combat Missions Team (AF)».

Μια

τέτοια αυτόνομη αεροπορική ομάδα, το

έγγραφο προβλέπει, ότι "Αναπτύσσει

σκεπτικό που κατευθύνεται στην επίτευξη

του στόχου, μηχανική μάθηση και τεχνικές

αλληλεπίδρασης χειριστή για να επιτρέψει

τη διοίκηση πολλαπλών, ομαδικών μη

επανδρωμένων αεροσκαφών". Αυτό θα

επιτύχει:

«Η αυτόνομη απόφαση και η ομαδική μάθηση επιτρέπουν στον TBM [Tactical Battle Manager- Διοικητή Τακτικής Μάχης] να μεγιστοποιήσει την αποτελεσματικότητα και την επιβίωση της ομάδας».

Ο

TBM αναφέρεται απευθείας σε ένα λογισμικό

αυτονομίας διαχείρισης μάχης για μη

επανδρωμένα αεροσκάφη.

Το

Πεντάγωνο, θέλει φυσικά να διασφαλίσει

ότι σε αυτό παραμένει ένα ανθρώπινο

εγχειρίδιο παράκαμψης, το οποίο το

έγγραφο περιγράφει ότι επιτρέπει σε

έναν ανθρώπινο επόπτη να «αναλάβει τον

έλεγχο» ή να ελέγξει χειροκίνητα το

σύστημα ».

Στόχευση κακών αντιπολεμικών bloggers

Ωστόσο,

η μεγαλύτερη πρόκληση, που δεν αναγνωρίζεται

πουθενά σε κανένα από τα έγγραφα, είναι

η διασφάλιση ότι η αυτοματοποιημένη

επιλογή στόχου της τεχνητής νοημοσύνης,

πράγματι επιλέγει ρεαλιστικές απειλές,

αντί να δημιουργεί ή να επιδιώκει ψευδώς

θετικές.

Σύμφωνα

με τον Χάρτη Πορείας των Ανθρώπινων

Συστημάτων, το Πεντάγωνο έχει ήδη

επιδείξει εκτεταμένες αναλυτικές

δυνατότητες τεχνητής νοημοσύνης πέρυσι,

σε ανάλυση κοινωνικών μέσων δικτύωσης

σε πραγματικό χρόνο, μέσω ζωντανής

άσκησης του ΝΑΤΟ.

Κατά

τη διάρκεια της άσκησης Trident Juncture - τη

μεγαλύτερη άσκηση του ΝΑΤΟ την τελευταία

δεκαετία- στρατιωτικό προσωπικό των

ΗΠΑ επεξεργάστηκε πάνω από 2 εκατομμύρια

σχετικά tweet, συμπεριλαμβανομένων και

τρολλ και άλλων διαφωνιών στον χώρο της

πληροφορίας, συμπεριλαμβανομένων 6

μηνών βασικής ανάλυσης. Επίσης «επιμέτρησαν

και ανέλυσαν πάνω από 20 χιλιάδες [δηλ.

20.000] tweets και 700 Instagrams κατά τη διάρκεια

της άσκησης».

Το

έγγραφο του Πενταγώνου τονίζει λοιπόν

ότι ο αμερικανικός στρατός και το ναυτικό

μπορούν ήδη «να παρέχουν επίγνωση της

κατάστασης σε πραγματικό χρόνο και

αυτοματοποιημένες αναλύσεις των

κοινωνικών μέσων δικτύωσης με χαμηλή

επάνδρωση, σε προσιτό κόστος», έτσι ώστε

οι στρατιωτικοί ηγέτες να μπορούν «να

δουν γρήγορα ολόκληρα μοτίβα ροής

δεδομένων και κρίσιμα δεδομένα » και

επομένως « διακριτές πληροφορίες με

εύκολη δυνατότητα δράσης ».

Ο

πρωταρχικός συντελεστής στην ανάλυση

κοινωνικών μέσων δικτύωσης στα πλαίσια

της άσκησης Trident Juncture του ΝΑΤΟ, η οποία

πραγματοποιήθηκε για δύο εβδομάδες από

τα τέλη Οκτωβρίου έως τις αρχές Νοεμβρίου

2015, ήταν μια ομάδα με επικεφαλής τον

επιστήμονα της πληροφορίας Καθηγητή

Nitin Agarwal του Πανεπιστημίου του Αρκάνσας

στην πόλη Little Rock.

Το

έργο του Agarwal χρηματοδοτήθηκε από το

Γραφείο Ναυτικής Έρευνας των ΗΠΑ, το

Ερευνητικό Εργαστήριο Πολεμικής

Αεροπορίας και το Γραφείο Έρευνας του

Στρατού και διεξήχθη σε συνεργασία με

τη Συμμαχική Διοίκηση του ΝΑΤΟ και το

Κέντρο Στρατηγικής Επικοινωνίας

Αριστείας του ΝΑΤΟ.

Οι

διαφάνειες από μια παρουσίαση

του συνεδρίου σχετικά

με την έρευνα δείχνουν ότι το έργο που

υποστηρίζεται από το ΝΑΤΟ, επιχείρησε

να εντοπίσει ένα εχθρικό δίκτυο blog κατά

τη διάρκεια της άσκησης, που περιείχε

«αντινατοϊκή και αντιαμερικανική

προπαγάνδα».

Μεταξύ

των επτά κορυφαίων ιστολογίων που

αναγνωρίστηκαν ως βασικοί κόμβοι

αντινατοϊκής κίνησης στο διαδίκτυο

ήταν οι ιστότοποι που διευθύνονταν από

τον Αντρέα Σπέκ, έναν αντιπολεμικό

ακτιβιστή, το War Resisters International (WRI), και

του Αιγύπτιου δημοκρατικού αγωνιστή

Maikel Nabil Sanad - μαζί με ορισμένους ιστότοπους

κατά του μιλιταρισμού στην ισπανική

γλώσσα.

Ο

Andreas Speck είναι πρώην υπάλληλος του WRI, το

οποίο είναι ένα διεθνές δίκτυο ειρηνικών

ΜΚΟ με γραφεία και μέλη στο Ηνωμένο

Βασίλειο, τη Δυτική Ευρώπη και τις

ΗΠΑ. Ένας από τους χρηματοδότες του

είναι το Joseph Rowntree Charitable Trust.

Το

WRI είναι αφιερωμένο στην έλλειψη βίας

και σε εκστρατείες κατά του πολέμου και

του μιλιταρισμού όλων των μορφών.

Τα

περισσότερα από τα ιστολόγια που

εντοπίστηκαν από το νατοϊκό πρότζεκτ

του Agarwal είναι συνδεδεμένα με το WRI, όπως

για παράδειγμα το nomilservice.com, το αιγυπτιακό

θυγατρικό σάιτ του WRI που ιδρύθηκε από

τον Maikel Nabil, το οποίο αγωνίζεται κατά

της υποχρεωτικής στρατιωτικής θητείας

στην Αίγυπτο. Ο Nabil προτάθηκε για το

βραβείο Νόμπελ Ειρήνης και μάλιστα

υποστηρίχθηκε από τον Λευκό Οίκο για

την συνειδητή του αντίθεση στις

στρατιωτικές θηριωδίες της Αιγύπτου.

Το

νατοϊκό πρότζεκτ προτρέπει:

"Αυτά τα 7 ιστολόγια πρέπει να παρακολουθούνται περαιτέρω."

Το

πρότζεκτ χαρακτηρίστηκε από τον Agarwal

ως μεγάλη επιτυχία: κατάφερε να εξαγάγει

635 δείκτες ταυτότητας μέσω μεταδεδομένων

(metadata)

από το δίκτυο blog, συμπεριλαμβανομένων

65 διευθύνσεων email, 3 "ατόμων" και 67

αριθμών τηλεφώνου.

Αυτό

είναι το ίδιο είδος μεταδεδομένων που

χρησιμοποιείται συνήθως για τον εντοπισμό

ανθρώπινων στόχων για επιθέσεις drone -

η συντριπτική

πλειονότητα των οποίων δεν είναι

τρομοκράτες ,

αλλά άμαχοι.

Οι

διαφάνειες της παρουσίασης του Agarwal

απαριθμούν τρία εργαλεία χρηματοδοτούμενα

από το Πεντάγωνο που δημιούργησε η ομάδα

του για αυτό το είδος ανάλυσης των

κοινωνικών μέσων δικτύωσης: τα

Blogtracker,

Scraawl και Focal

Structures Analysis.

Ο

χαρακτηρισμός ενός Αιγύπτιου δημοκρατικού

ακτιβιστή όπως ο Maikel Nabil ως εχθρική

οντότητα που προωθεί προπαγάνδα κατά

του ΝΑΤΟ και των ΗΠΑ, δείχνει ότι όταν

αυτά τα αυτοματοποιημένα εργαλεία

τεχνητής νοημοσύνης εφαρμόζονται σε

πολεμικές σκηνές σε σύνθετα περιβάλλοντα

(σκεφτείτε το Πακιστάν, το Αφγανιστάν

και την Υεμένη), η δυνατότητα να

αναγνωριστούν άτομα ή ομάδες που

επικρίνουν την αμερικανική πολιτική,

ως τρομοκρατικές απειλές, είναι πολύ

ρεαλιστική.

Αυτή

η περίπτωση καταδεικνύει πόσο βαθιά

προβληματικές είναι οι φιλοδοξίες

αυτοματισμού του Πενταγώνου. Ακόμη

και με την τελική επίβλεψη ανεξάρτητων

ανθρώπινων εμπειρογνωμόνων και αναλυτών,

εντελώς ειρηνικοί υπέρμαχοι της

δημοκρατίας που αντιτίθενται στον

πόλεμο, χαρακτηρίζονται από το ΝΑΤΟ ως

πιθανές απειλές κατά της εθνικής

ασφάλειας που απαιτούν περαιτέρω

επιτήρηση.

Συμπίεση της αλυσίδας θανάτωσης

Πολλοί

συχνά υποθέτουν ότι η οδηγία 3000.09 του

υπουργείου άμυνας που εκδόθηκε το 2012,

«Αυτονομία στα συστήματα όπλων»,

περιορίζει τις αποφάσεις θανάτωσης σε

ανθρώπινους χειριστές σύμφωνα με την

ακόλουθη διάταξη στην ενότητα 4:

«Τα αυτόνομα και ημιαυτόνομα οπλικά συστήματα πρέπει να σχεδιάζονται για να επιτρέπουν στους διοικητές και τους χειριστές να ασκούν τα κατάλληλα επίπεδα ανθρώπινης κρίσης σχετικά με τη χρήση βίας».

Μετά

από αρκετές παραγράφους που υπογραμμίζουν

την αναγκαιότητα της επιλογής στόχου

και της εκτέλεσης υπό την επίβλεψη ενός

ανθρώπινου χειριστή, η οδηγία συνεχίζει

να ανοίγει τη δυνατότητα ανάπτυξης

αυτόνομων οπλικών συστημάτων χωρίς

ανθρώπινη επίβλεψη, αν και με την ειδική

έγκριση ανώτερων αξιωματούχων του

Πενταγώνου:

«Αυτόνομα οπλικά συστήματα μπορούν να χρησιμοποιηθούν για την εφαρμογή μη θανατηφόρας, μη κινητικής δύναμης, όπως κάποιες μορφές ηλεκτρονικών επιθέσεων, εναντίον υλικών στόχων… Αυτόνομα ή ημι-αυτόνομα οπλικά συστήματα που προορίζονται να χρησιμοποιηθούν με τρόπο που δεν εμπίπτει στα εδάφια 4.γ. (1) έως 4.γ. (3) πρέπει να εγκριθούν από τον Υφυπουργό Άμυνας Πολιτικής (USD (P)) · τον Υφυπουργός Άμυνας για Απόκτηση, Τεχνολογία και Εφοδιαστική (USD (AT&L)) · και το CJCS πριν από την επίσημη ανάπτυξη και ξανά πριν από το πεδίο.

Αντί

να απαγορεύει την ανάπτυξη αυτόνομων

θανατηφόρων οπλικών συστημάτων, η οδηγία

απλώς ενοποιεί όλες αυτές τις εξελίξεις

υπό τη ρητή εξουσιοδότηση των κορυφαίων

αρχηγών τεχνολογίας του Πενταγώνου.

Ακόμη

χειρότερα, η οδηγία λήγει στις 21 Νοεμβρίου

2022 – όπου τότε περίπου αναμένεται να

τεθεί σε λειτουργία μια τέτοια τεχνολογία.

Πράγματι,

αργότερα εκείνο το έτος, ο αντισυνταγματάρχης

Jeffrey S. Thurnher, δικηγόρος του στρατού των

ΗΠΑ στο Τμήμα Διεθνούς Δικαίου του

Αμερικανικής Ναυτικής Σχολής Πολέμου,

δημοσίευσε ένα

position paper

στο έντυπο Joint Force Quarterly του Εθνικού

Αμυντικού Πανεπιστημίου.

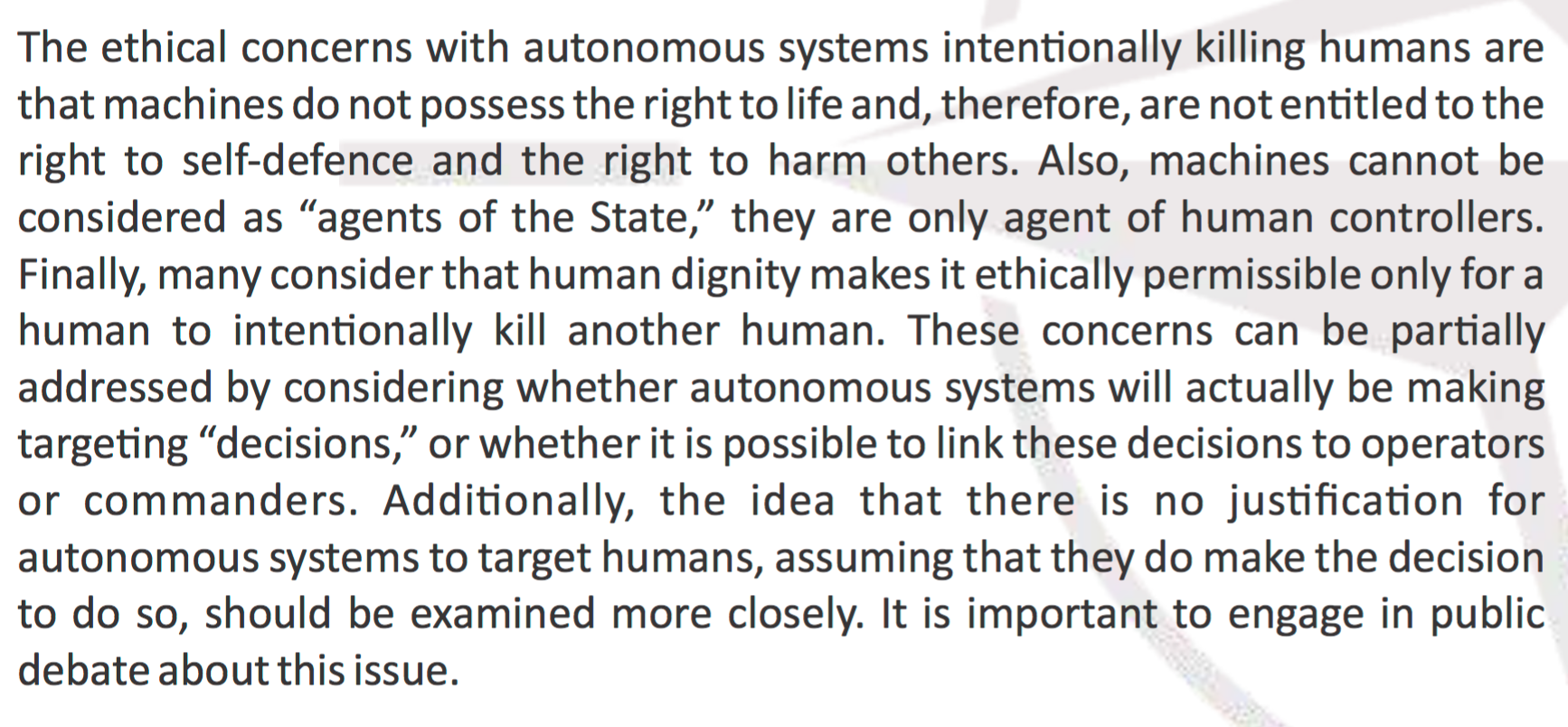

Αν

αυτά τα κουταβάκια αποκτούσαν

αυτοσυνειδησία θα ήταν γλυκύτερα;

Συνέστησε

ότι δεν υπήρχαν ουσιαστικά νομικά ή

ηθικά εμπόδια στην ανάπτυξη πλήρως

αυτόνομων ρομπότ δολοφόνων - εφ 'όσον

τέτοια συστήματα έχουν σχεδιαστεί με

τέτοιο τρόπο ώστε να διατηρούν την

ομοιότητα της ανθρώπινης εποπτείας

μέσω «κατάλληλων μέτρων ελέγχου».

Στα

συμπεράσματα της συγγράματος του, με

τίτλο “ Κανένας άνθρωπος στον έλεγχο:

Νομικές Επιπτώσεις της Πλήρους Αυτόνομης

Στόχευσης-No

One At The Controls: Legal Implications of Fully Autonomous

Targeting” ,

ο Thurnher έγραψε:

«Τα LAR [θανατηφόρα αυτόνομα ρομπότ] έχουν τη μοναδική δυνατότητα να λειτουργούν με ρυθμό γρηγορότερο από ό, τι μπορεί να επιτύχει ο άνθρωπος και να προκαλέσουν θανατηφόρο χτύπημα ακόμη και όταν έχουν διακοπεί οι σύνδεσμοι επικοινωνίας. Η αυτόνομη τεχνολογία στόχευσης πιθανότατα θα εξαπλωθεί σε έθνη και ομάδες σε όλο τον κόσμο. Για να αποφευχθεί η υπέρβαση από τους αντιπάλους τους, οι Ηνωμένες Πολιτείες θα πρέπει να δεσμευτούν πλήρως ώστε να εκμεταλλευτούν το δυναμικό μιας πλήρως αυτόνομης στόχευσης. Οι νομικές ανησυχίες δεν φαίνεται να αποτελούν εμπόδιο για την κατασκευσή ή την ανάπτυξη στο πεδίο της μάχης των αυτόνομων θανατηφόρων ρομπότ (LAR). Έτσι, οι επιχειρησιακοί διοικητές πρέπει να αναλάβουν το προβάδισμα ώστε να καταστήσουν αυτήν την αναδυόμενη τεχνολογία ως έναν πραγματικό πολλαπλασιαστή ισχύος για την συμμαχική δύναμη. "

Ο

αντισυνταγματάρχης Thurnher έγινε νομικός

σύμβουλος του NATO στο Σώμα Rapid Deployable, στο

Munster της Γερμανίας. Υπό αυτήν την

ιδιότητα, συνεισέφερε σε ένα ελάχιστα

γνωστό επίσημο

έγγραφο καθοδήγησης πολιτικής του 2014

για τη Συμμαχική Διοίκηση Μετασχηματισμού

του ΝΑΤΟ ,

ονόματι “ Αυτονομία

στα Αμυντικά Συστήματα” .

Το

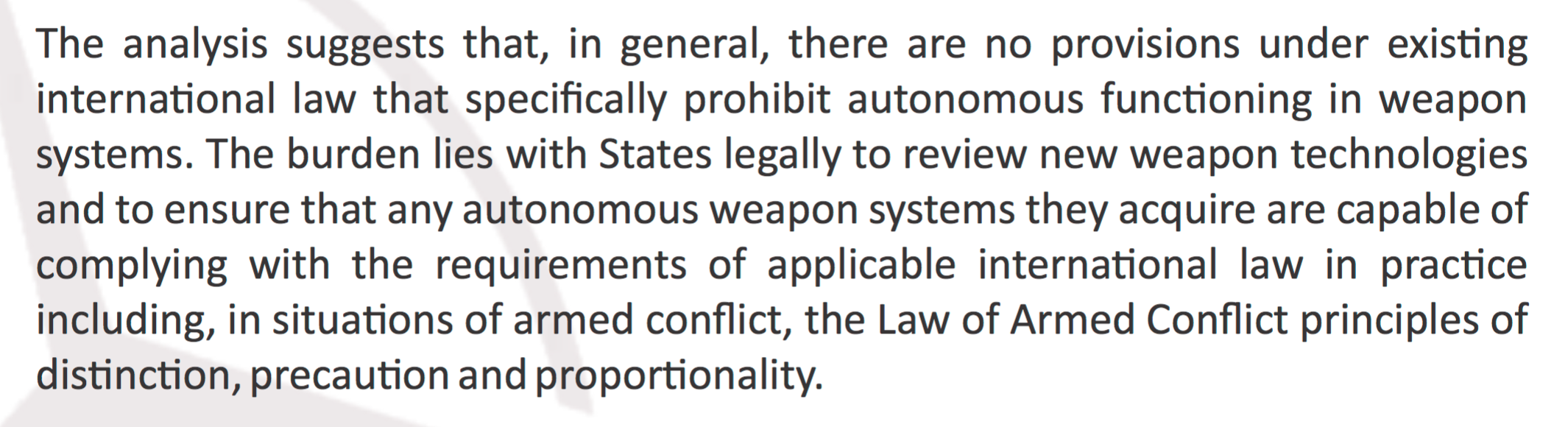

έγγραφο του ΝΑΤΟ, το οποίο στοχεύει στην

παροχή εξειδικευμένων νομικών συμβουλών

από εμπειρογνώμονες σε κυβερνητικούς

υπεύθυνους χάραξης πολιτικής, καθορίζει

μια θέση στην οποία η ανάπτυξη αυτόνομων

οπλικών συστημάτων για θανατηφόρα μάχη

(ιδίως η ανάθεση αποφάσεων στόχευσης

και δολοφονίας σε πράκτορες-μηχανές)

θεωρείται απολύτως νόμιμη κατ 'αρχήν.

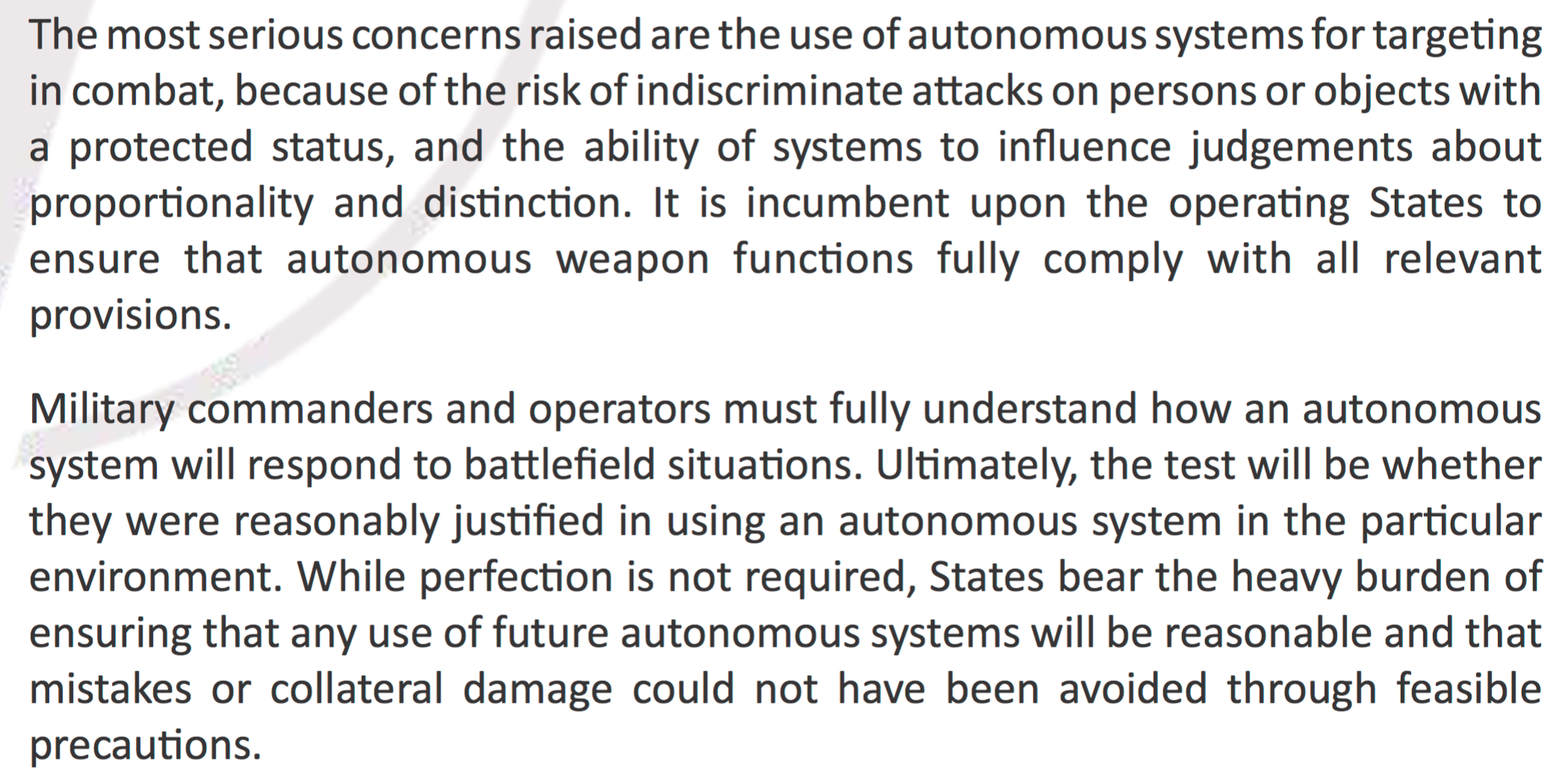

Αποτελεί

ευθύνη συγκεκριμένων κρατών, καταλήγει

το έγγραφο, να διασφαλιστεί ότι τα

αυτόνομα συστήματα λειτουργούν σύμφωνα

με το διεθνές δίκαιο στην πράξη – ένας

περιορισμός που ισχύει επίσης για τη

χρήση αυτόνομων συστημάτων επιβολής

του νόμου και αυτοάμυνας.

Στο

μέλλον, ωστόσο, το έγγραφο του ΝΑΤΟ

επισημαίνει την ανάπτυξη αυτόνομων

συστημάτων που μπορούν «να προσδιορίσουν

αξιόπιστα πότε ένα προβλεπόμενο αλλά

ακούσιο χτύπημα στους πολίτες είναι

ηθικά επιτρεπτό».

Αναγνωρίζοντας

ότι επί του παρόντος μόνο οι άνθρωποι

είναι σε θέση να «κρίνουν σχετικά με αν

είναι ηθικά επιτρεπτό ένα προβλεπόμενο

αλλά ακούσιο χτύπημα στους πολίτες

(παράπλευρες απώλειες)», το έγγραφο

πολιτικής του ΝΑΤΟ καλεί τα κράτη που

αναπτύσσουν αυτόνομα οπλικά συστήματα,

να διασφαλίσουν ότι τελικά τα συστήματα

αυτά «είναι σε θέση να ενσωματωθούν με

μεθοδολογίες εκτίμησης παραπλεύρων

ζημιών», ώστε να ανατίθενται οι αποφάσεις

στόχευσης και θανάτωσης αναλόγως.

Η

θέση του ΝΑΤΟ είναι ιδιαίτερως

αξιοσημείωτη, δεδομένου ότι το διεθνές

δίκαιο - όπως οι Συμβάσεις της Γενεύης

- ορίζει ότι οι προβλεπόμενοι θάνατοι

αμάχων που προκαλούνται από μια

στρατιωτική δράση είναι σκόπιμοι και

εκκούσιοι, ακριβώς επειδή είχαν

προβλεφθεί, αλλά η στρατιωτική δράση

τέθηκε σε εφαρμογή.

Το

Καταστατικό του Διεθνούς Ποινικού

Δικαστηρίου (ΔΠΔ) προσδιορίζει

τέτοιες ενέργειες όπως «εγκλήματα

πολέμου» ,

εάν δεν μπορεί να αποδειχθεί ένα

δικαιολογημένο και άμεσο στρατιωτικό

πλεονέκτημα:

«… κάνοντας τον άμαχο πληθυσμό ή μεμονωμένους πολίτες, που δεν συμμετέχουν άμεσα στις εχθροπραξίες, αντικείμενο επίθεσης. ξεκινώντας μια επίθεση γνωρίζοντας ότι μια τέτοια επίθεση θα προκαλέσει τυχαία απώλεια αμάχων, τραυματισμούς αμάχων ή ζημιά σε αντικείμενα πολιτών που θα ήταν σαφώς υπερβολικό σε σχέση με το αναμενόμενο συγκεκριμένο και άμεσο στρατιωτικό πλεονέκτημα ·… κάνοντας αντικείμενα πολιτών, δηλαδή αντικείμενα που δεν είναι στρατιωτικοί στόχοι, το στόχο της επίθεσης. "

Και

το σύνηθες

διεθνές δίκαιο αναγνωρίζει

τις ακόλουθες πράξεις ως εγκλήματα

πολέμου:

«… Ξεκινώντας μια αδιάκριτη επίθεση με αποτέλεσμα απώλεια ζωής ή τραυματισμό πολιτών ή ζημιά σε πολιτικά αντικείμενα. Ξεκινώντας μια επίθεση εναντίον έργων ή εγκαταστάσεων που περιέχουν επικίνδυνες δυνάμεις γνωρίζοντας ότι μια τέτοια επίθεση θα προκαλέσει υπερβολική τυχαία απώλεια αμάχων, τραυματισμό σε πολίτες ή ζημιά σε πολιτικά αντικείμενα.

Με

άλλα λόγια, η επίσημη πολιτική καθοδήγησης

του ΝΑΤΟ σχετικά με τα αυτόνομα οπλικά

συστήματα, δικαιολογεί τη δυνατότητα

εγκλημάτων πολέμου από αυτά. Το

έγγραφο πραγματικά ενθαρρύνει τα κράτη

να αναπτύξουν τελικά αυτόνομα

όπλα ικανά να προκαλέσουν «προβλεπόμενη

αλλά ακούσια» βλάβη στους πολίτες, στο

όνομα της εξασφάλισης ενός «νόμιμου»

στρατιωτικού πλεονεκτήματος.

Ωστόσο,

το έγγραφο του ΝΑΤΟ δεν σταματά

εκεί. Προχωρεί ακόμη και στο επιχείρημα

ότι οι υπεύθυνοι χάραξης πολιτικής που

εξετάζουν την ανάπτυξη αυτόνομων οπλικών

συστημάτων για θανατηφόρες μάχες, θα

πρέπει να προβληματιστούν σχετικά με

το ενδεχόμενο, ότι οι παράπλευρες

απώλειες αμάχων θα ελαχιστοποιηθούν,

με την ανάθεση αποφάσεων στόχευσης και

δολοφονίας σε πράκτορες-μηχανές.

Skynet, κανένας;

Μια

νέα έκθεση από

τον Paul Scharre, ο οποίος ηγήθηκε της ομάδας

εργασίας του Πενταγώνου που συνέταξε

την οδηγία 3000.09 του υπουργείου άμυνας

και τώρα είναι επικεφαλής του προγράμματος

μελλοντικού πολέμου στο Κέντρο Νέας

Αμερικανικής Ασφάλειας στην Ουάσιγκτον,

δεν μασάει τα λογια της για τους δυνητικά

«καταστροφικούς» κινδύνους που μπορεί

να επιφέρει η εμπιστοσύνη σε αυτόνομα

οπλικά συστήματα.

«Με

ένα αυτόνομο όπλο», γράφει, «μια ενδεχόμενη

ζημιά, πριν μπορέσει να παρέμβει ένας

ανθρώπινος ελεγκτής, θα μπορούσε να

είναι πολύ μεγαλύτερη…

«Στην πιο ακραία περίπτωση, ένα αυτόνομο όπλο θα μπορούσε να συνεχίσει να εμπλέκει ακατάλληλους στόχους μέχρι να εξαντλήσει τα πυρομαχικά του, ενδεχομένως σε μια ευρεία περιοχή. Εάν αυτή η αποτυχία αναπαραχθεί σε άλλα αυτόνομα όπλα του ίδιου τύπου, ένας στρατός θα μπορούσε να αντιμετωπίσει την ανησυχητική προοπτική ενός μεγάλου αριθμού αυτόνομων όπλων να αποτυγχάνουν ταυτόχρονα, με δυνητικά καταστροφικές συνέπειες. "

Ο

Scharre επισημαίνει ότι «τα αυτόνομα όπλα

ενέχουν το νέο κίνδυνο μαζικής

αδελφοκτονίας ,

με μεγάλο αριθμό όπλων να στρέφονται

εναντίον συμμαχικών δυνάμεων», λόγω

οποιονδήποτε πιθανών λόγων, όπως

«χάκινγκ, εχθρική χειραγώγηση συμπεριφοράς,

απρόσμενες αλληλεπιδράσεις με το

περιβάλλον ή απλές δυσλειτουργίες ή

σφάλματα λογισμικού.»

Σημειώνοντας

ότι στη βιομηχανία λογισμικού, για κάθε

1.000 γραμμές κώδικα, υπάρχουν μεταξύ 15

και 50 σφαλμάτων, ο Scharre επισημαίνει ότι

τέτοια οριακά σφάλματα ρουτίνας θα

μπορούσαν εύκολα να συσσωρευτούν και

να δημιουργήσουν απρόσμενα αποτελέσματα

που θα μπορούσαν να μη προβλεφθούν ακόμη

και από τις πιο αυστηρές δοκιμές και

μεθόδους επικύρωσης.

Όσο

πιο περίπλοκο είναι το σύστημα, τόσο

πιο δύσκολο θα είναι να επαληθευτεί και

να παρακολουθηθεί η συμπεριφορά του

συστήματος υπό όλες τις πιθανές συνθήκες:

«… ο αριθμός των πιθανών αλληλεπιδράσεων

εντός του συστήματος και με το περιβάλλον

του είναι απλά πολύ μεγάλος.»

Τα

έγγραφα που συζητήθηκαν εδώ δείχνουν

ότι το Πεντάγωνο προσπαθεί σκληρά να

αναπτύξει τρόπους μετριασμού αυτών των

κινδύνων.

Όμως,

όπως καταλήγει ο Scharre, «αυτοί οι κίνδυνοι

δεν μπορούν να εξαλειφθούν πλήρως. Τα

σύνθετα, στενά συνδεδεμένα συστήματα

είναι εγγενώς ευάλωτα σε «κανονικά

ατυχήματα». Ο κίνδυνος ατυχημάτων

μπορεί να μειωθεί, αλλά ποτέ δεν μπορεί

να εξαλειφθεί πλήρως. "

Καθώς

επιταχύνεται η πορεία προς την αυτονομία

και την πολυπλοκότητα της τεχνητής

νοημοσύνης, το ίδιο συμβαίνει και με

τον κίνδυνο τα αυτόνομα οπλικά συστήματα

τελικά να φέρουν όλεθρο.

Στο

παρακάτω βίντεο το ρομπότ Atlas

που

αναπτύχθηκε για λογαριασμό της DARPA

από

την Boston

Dynamics, επιδεικνύει

τις δυνατότητες του:

- Λήψη συνδέσμου

- X

- Ηλεκτρονικό ταχυδρομείο

- Άλλες εφαρμογές

Σχόλια

ΟΤΙ ΚΑΙ ΝΑ ΚΑΤΑΣΚΕΥΑΖΟΥΝ ΠΑΝΤΑ ΘΑ ΥΠΑΡΧΟΥΝ ΑΝΤΙΜΕΤΡΑ....

ΑπάντησηΔιαγραφήΕάν υπάρχουν αντίμετρα, τότε καλό θα ήταν να μπούνε σε ισχύ.

ΔιαγραφήΑπο ότι φαίνεται όμως υπάρχουν μόνο "μέτρα" και είναι εναντίον του ανθρώπου.